ЧАСТЬ 2. РАБОТА С ВИДЕО

ГЛАВА 9. КРАТКИЕ СВЕДЕНИЯ О ТЕЛЕВИДЕНИИ [46-49]

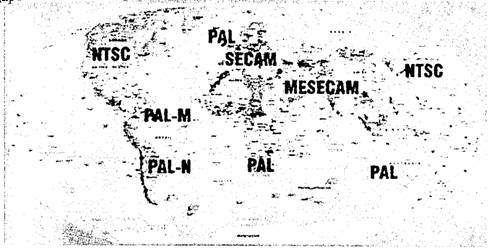

Политическая карта мира исполосована жирными линиями границ и раскрашена в разные цвета. Особенно заметна чересполосица красок в таких густонаселенных местах, как Европа или же Ближний Восток. Во времена вражды правительства стран соседей старались всячески оградить свое население от «тлетворного» влияния, глуша радиопередачи и делая невозможным прием телевидения из-за «бугра». Многие преуспели в этом, придумав собственные стандарты, несовместимые с принятыми в других странах. Сыграла свою роль и коммерция - никто ведь не хочет, чтобы его фильмы бесплатно смотрели миллионы зрителей другого государства. Так и появилось множество разноликих стандартов — сначала черно-белого, а затем уже цветного телевидения.

«Как низко ПАЛ СЕКАМ». Эта шутливая фраза имела популярность во времена, когда в бывший СССР стали из-за границы привозить видеомагнитофоны и кассеты с записями. Бывало, достанешь редкий фильм на один вечер, подключишь видеомагнитофон к своему старому телевизору, а на экране - только черно-белое кино, причем без звука, а то и вовсе ничего. Так многие наши граждане убеждались, что «железный занавес» проходил не только по границе, но и в эфире. Некоторые проклинали французский стандарт SECAM, принятый когда-то сгоряча, по чисто политическим соображениям. Действительно, до 1965 года наши телевизионщики в основном ориентировались на американский стандарт NTSC, вещание в котором началось в США еще в 1953 оду. Но даже в богатой Америке цветные телевизоры с трудом находили дорогу в дома зрителей. Стоили они довольно дорого, но не это главное - краски на Р ах были далеки от реальности. Лицо симпатичной дикторши вместо приятного розового цвета приобретало то кирпичный, а то и вообще фиолетовый оттенок. Виновником этого являлся не только кинескоп с несовершенной маской, которая направляет электронный луч к нужному зернышку люминофора но и трансляционные каналы связи, передавшие сигнал, например, от Вашингтона до Сан-Франциско. Дело в том, что стандарт NTSC обеспечивает высокую четкость по цвету, но крайне привередлив к качеству канала передачи. Поэтому среди инженеров до сих пор ходит легенда о том, как каждое утро, до начала передач, американцы усаживали перед телекамерой стандартно накрашенную девушку и по цвету ее лица корректировали фазовые искажения в каналах связи. Постепенно они сумели подтянуть уровень своих линий междугородней связи (спутников связи тогда еще не было) и обеспечить приемлемое качество цветов на экранах, но на это ушло более 10 лет и огромные по тем времена деньги.

Пробные передачи в стандарте NTSC в начале 60-х лет велись и у нас в Москве, телевизионная промышленность готовилась сделать родной стране и партии трудовой подарок к очередному съезду или же к празднику. Однако если багровый цвет лиц трудящихся на ноябрьской демонстрации еще как-то можно было объяснить, то фиолетовые флаги никак не проходили по идеологическим соображениям. На близких расстояниях краски получались еще более или менее правдоподобными, но на дальних — ретрансляционные линии вносили недопустимые искажения. При наших масштабах - от Москвы до Владивостока - затраты на модернизацию линий связи могли превысить текущие финансовые возможности.

Но тут наступил 1965 год, и президент Франции Де Голь захотел вдруг выйти из НАТО. Советское руководство пришло от этого в восторг и решило сделать ряд встречных шагов по сближению со строптивым генералом. И во время одного из визитов на высшем уровне, без каких бы то ни было консультаций со специалистами, наши заявили о принятии французского стандарта SEC AM. После этого министру связи оставалось ответить «Есть!» и запросить деньги на технологию и оборудование из Франции. Так в СССР и в «братских странах социалистического лагеря» появилась система, несовместимая с общепринятой в большинстве стран Западной Европы.

Разумеется, в то время еще имелась возможность договориться и принять единый стандарт. Но тогдашним руководителям еще не было знакомо слово «разрядка», речь шла лишь о мирном сосуществовании и соревновании с целью выяснить, чья же система (не телевизионная, а политическая) лучше. Поэтому крайне нежелательным считалось, чтобы граждане из братской ГДР свободно смотрели передачи, предназначенные для западных немцев. Хорошо хоть, что метровые и дециметровые радиоволны, на которых ведется телевещание, распространяются не так далеко - в пределах прямой видимости. Для того чтобы увеличить зону охвата, требуется построить высокую телебашню, и их возводили с обеих сторон границы. Надо также заметить, что ограниченность зоны вещания - это одна из объективных причин появления на свет множества несовместимых стандартов.

Немцы, долгие годы наблюдавшие со стороны за мучениями американцев с их системой NTSC, тоже не дремали. В 1963 году Вальтер Брух из компаний Telefunken продемонстрировал систему PAL, в которой цветовая информация передавалась дважды в двух соседних строках, но в противофазе. За счет усреднения удавалось почти полностью подавить характерные цветовые искажения. Конечно, четкость в цвете при этом снижалась вдвое, однако на глаз это было практически незаметно. По существу, PAL - это усовершенствованная NTSC, только для ее реализации требуется прецизионная линия задержки сигнала на одну строку. Сегодня это наиболее распространенная система цветного телевидения, которую использует около ста стран Западной Европы, Азии и Африки. Даже некоторые наши бывшие соседи по соцлагерю, Польша, к примеру, полностью перешли на PAL и влились в европейское сообщество. Но в то время отечественная промышленность не сумела освоить массовое производство дешевых линий задержки сигнала с точностью не хуже нескольких пикосекунд а идти на поклон к «реваншистам» из ФРГ очень не хотелось.

Сепаратный SECAM. Франция всегда шла своим особым путем и при появлении цветного телевидения вспомнила об изобретении инженера Анри де Франса. Еще в 1954 году он создал систему, свободную от недостатков американской. SECAM в переводе с французского означает «поочередная передача цветов и память», и в полном соответствии с этим в ней в разных строках поочередно передаются красный и синий сигналы, а в приемнике для восстановления недостающей информации имеется линия задержки (память) на одну строку. Но самое главное, что для передачи сигналов цветности в ней используются частотная модуляция, делающая ее нечувственной к помехам и искажениям в каналах связи.

Как и PAL, SECAM снижает цветовую четкость в два раза по сравнению с NTSC, но это не так страшно, как фиолетовый оттенок на лице диктора. После заключения политического соглашения в 1965 году система еще пару лет дорабатывалась совместно специалистами Франции и СССР, и после ряда модификаций она наконец-то была принята для вещания одновременно у нас и во Франции. В 1967 году в СССР с большой помпой отмечалось 50-летие социалистической революции (называемой теперь октябрьским переворотом) и к этой дате приурочили торжественное открытие передач в цвете. Улучшения в системы продолжались в процессе эксплуатации, и ее современная версия называется SECAM-III. В лучшие годы SECAM использовали более 50-ти стран Европы (бывшего СЭВ), Азии и Африки (в основном бывшие французские колонии).

За прошедшие 38 лет с момента принятия SECAM в нашей стране много раз возникали споры: стоило ли равняться на французов и не сменить ли нам стандарт на более распространенный PAL. Сейчас, в связи с интенсивным переходом к цифровым технологиям эти споры поутихли - «цифра» гарантирует не только полную совместимость всех телевизоров нового поколения, но и гораздо более высокую четкость, стабильность и качество цветов картинки. Менять систему, зная, что через 5-7 лет придется все равно переходить к «цифре» и выбрасывать аналоговое студийное оборудование, сегодня уже нет никакого смысла.

В настоящее время все телестудии США в массовом порядке переходят на цифровой стандарт HDTV, а владельцам старых (и новых) аналоговых телевизоров приходится покупать специальные приставки (set-top-boxes). В Европ внедряется наземное цифровое телевидение в стандарте DVB-T, а спутниковое у них уже давно почти все цифровое. Даже у нас в России ведутся передачи в стандарте DVB-T, а многие сотни тысяч домов оснащены тарелками и цифровыми ресиверами для приема передач со спутников. Более того, цифровое телевидение сегодня приходит в дома жителей крупных городов по кабелю.

Да и на DVD фильмы записаны в цифре - в форматах MPEG-2 и MPEG-4, и лишь на выходе преобразуются в аналоговую форму (NTSC или PAL), понятную для наших телевизоров. Так что «лучше цифр могут быть только цифры», но с еще более высоким разрешением, как американское HDTV.

Немного истории. Исторически так сложилось, что каждая промышленно развитая страна создала свой стандарт на телевизионное вещание, хотя в то время можно было выработать и единый международный стандарт. Одной из причин такого разнобоя явилось то, что метровые и дециметровые волны распространяются в атмосфере почти как свет — в пределах прямой видимости. До эпохи цветного телевидения появилось целых 13 стандартов черно-белого телевидения, причем каждый из них имел свою сетку частот. Стандартов цветного телевидения, к счастью, оказалось значительно меньше — всего 3.

Уже при создании черно-белого телевидения были учтены основные особенности человеческого зрения: угол обзора, составляющий для большинства людей 600 угловых минут, разрешающая способность глаза (1 угловая минута), а также инерционность зрения. Исходя из этого, вертикальное разрешение аналогового телевидения составляет около 600 строк. Например, американский NTSC содержит 525 строк, европейский - 625. Тем не менее, в Великобритании существовал стандарт с числом строк 405, а во Франции — с 819, но сейчас и они перешли на 625 строк.

Выбор частоты кадров также основан на физиологии человеческого зрения. Еще первые эксперименты с немым кино показали, что человек воспринимает движение как непрерывное при частоте смены кадров более 12 раз в секунду, а мерцание экрана становится практически незаметным при частоте более 50 кадров в секунду. В первых опытах по передаче изображения передающей трубкой служил фотоэлектронный умножитель с диском со спирально-расположенными отверстиями (диск Нипкова), а вместо кинескопа использовалась плоская (размеров с большую почтовую марку) неоновая лампа с таким же диском. Для обеспечения устойчивости изображения диски вращались подключенными к осветительной сети синхронными двигателями. По этой причине частота смены кадров оказалась привязанной к национальным электросетям: в Америке это 60 Гц, в Европе - 50 Гц. Когда появились кинескопы, выяснилось, что для 50 Гц (60 Гц в США) требовалось слишком широкая полоса передаваемых частот. Было принято компромиссное решение: снизить частоту смены кадров до 25 (30) Гц, а чтобы глаз меньше уставал от мерцания экрана, частоту кадровой развертки оставить прежней и передавать сначала нечетные, а затем четные строки (сделать чересстрочную развертку). Первоначально для показа фильмов по телевизору выбрали формат экрана 4:3, соответствующий формату киноэкрана.

Отсюда берут начало два базовых стандарта черно-белого телевидения - Американский (FCC) и Европейский (CCIR). Тем не менее, не все европейские страны приняли стандарт CCIR, в СССР был разработан собственный вариант - OIRT, а Франция и Швейцария сохранили свои стандарты.

Каждая страна выделила себе для передачи телевизионных сигналов свои частотные диапазоны. Например, собственные стандарты на частоты телеканалов имеют Австралия, Италия, Марокко, Новая Зеландия, Китай, Страны СНГ, Ирландия, Южная Африка, Франция, Япония и США. К счастью, когда вещание освоили дециметровые волны (ДМВ), большинство стран смогли договориться, и стандартов на ДМВ осталось всего три. Они отличаются друг от друга частотными интервалами и полосой канала: в Европе это каналы 21.. .69 (от 470 до 854 МГц с полосой 8 МГц), в Америке - каналы 14...83 (470...884 МГц с полосой 6 МГц) и в Австралии - каналы 28...69 (526...813 МГц с полосой 7 МГц).

Интересно, какое максимальное количество программ сможет принимать телевизор, если передатчики используют всю разрешенную сетку частот? В Западной Европе (стандарт CCIR) телевизионные каналы распределены следующим образом. Метровые каналы с именами Е2-Е12 (всего 11), кабельные каналы S1-S20 (всего 20), кабельные каналы гипердиапазона Н1-Н19 (всего 19) и дециметровые каналы 21-69 (всего 49). Если телевизор не подключен к кабельной сети, то максимальное число программ равно 60. В Восточной Европе (стандарт OIRT) распределение каналов отличается только количеством каналов метрового диапазона. Метровых каналов с именами R1-R12 не 11, как в Западной Европе, а 12.

Да будет цвет! При создании системы цветного телевидения основной задачей разработчиков являлось обеспечение ее совместимости с черно-белым телевидением. Нельзя было лишать владельцев черно-белых телевизоров возможности смотреть передачи цветного телевидения (в черно-белом варианте), а владельцев цветных телевизоров — черно-белые передачи. Поэтому пришлось размещать более информативное цветное изображение в прокрустово ложе черно-белого стандарта. Тогда в ход пошли разные хитрости, среди которых -физиология цветного зрения человека и радиотехническая наука, способная зашифровать сигналы цветного телевидения и передать их вместе с сигналами черно-белого телевидения.

Разрешающая способность человеческого глаза зависит от цвета: в красном она в 4, а в синем в 10 раз меньше, чем в белом или зеленом. Такой перекос существенно позволил сузить полосу при передаче сигналов цветности. В новом формате решили разделить сигналы черно-белого телевидения (яркостной нал) и цветного (канал цветности). При приеме цветным телевизором черно-белого изображения канал цветности просто выключается, а при приеме черно-белым телевизором цветного - работает только канал яркости. Так было соблюдено главное требование обеспечения совместимости. Теперь осталось сделать, чтобы сигнал цветности, «вплетенные» в яркостной сигнал, не были заметны черно-белом телевизоре. Для этого пришлось передавать сигналы не и синего цветов, а так называемые цветоразностные, предоставляющие собой разность соответствующих сигналов цветности и яркости. При таком способе в слабонасыщенном изображении цветоразностные сигналы практически отсутствуют и незаметны на черно-белом телевизоре. Эти правила — общие для всех систем цветного телевидения, но далее каждый разработчик пошел своим путем.

Система NTSC M (National Television System Committee), которую чаще называют NTSC 3.58, была разработана в США и принята для вещания в 1953 году. В настоящее время вещание по этой системе ведется не только в США, но и в Канаде, Японии, Южной Корее, Тайване и в ряде стран американского континента. Особенностью системы NTSC является то, что оба цветоразностных сигнала передаются в каждой строке растра, чем достигается высокая цветовая четкость по вертикали. Чтобы между цветоразностными сигналами не возникало взаимных влияний, а также не было заметно мелкой сетки поднесу, щей, на черно-белом телевизоре использована квадратурная балансная модуляция.

Основным недостатком системы NTSC 3.58 является ее высокая чувствительность к дифференциально-фазовым искажениям, которые возникают в каналах передачи телевизионного сигнала по радиорелейным линиям и спутниковым системам. Фазовые ошибки больше 5 градусов вызывают заметное искажение цветов, которое в телевизорах NTSC корректируется специальной регулировкой TINT.

NTSC стала основной при разработке системы PAL (Phase Alternation Line), которая была реализована в Германии инженерами компании Telefunken в 1963 году. Разработчикам удалось устранить основной недостаток системы NTSC — ее чувствительность к дифференциально-фазовым искажениям путем фазовой манипуляции красного цветоразностного сигнала. За счет электрического сложения прямого и задержанного сигналов цветности в каждой из двух соседних строк фазовые ошибки величиной до 35 градусов полностью компенсируются и сводятся к уменьшению амплитуды цветоразностных сигналов, что приводит лишь к незначительному уменьшению цветовой насыщенности. При этом полная информация о цветности у системы PAL содержится в паре строк растра, поэтому разрешение по вертикали для цветного изображения уменьшается до 288 строк, однако это практически незаметно. Частота поднесущей цветности выбрана равной 4,43361825 МГц. Для получения сигнала предыдущей строки необходима линия задержки, требования к которой очень высоки. Не вдаваясь в подробности, отметим, что время задержки линии составляет 63,94325 мкс, а не 64 мкс, что связано с компенсацией фазовых искажений. Разброс времени задержки такой линии не должен превышать 5 нс.

SECAM (SEqucncional Couler A Memoir) основана на иных принципах и существенно отличается от других систем цветного телевидения. Ее особенность заключается в последовательной (построчной) передаче цветоразностных сигналов красного и синего на частотно-модулированных поднесущих частотах 4,25 и 4,40625 МГц, использовании при декодировании цветности линии задержки на одну строку (64 мкс) и электронного коммутатора прямого и задержанного сигналов. Поэтому здесь, как и у системы PAL, полная информация для декодирования цветности содержится в двух соседних строках растра, а таких пар на видимую часть кадра приходится 288. Важнейшим преимуществом системы SECAM считается ее нечувствительность к дифференциально-фазовым искажениями перекрестным искажениями цветоразностных сигналов.

Теоретически качество цветного изображения в системе SECAM может быть даже лучше, чем в PAL, однако на практике дело обстоит сложнее. Система SECAM нечувствительна к дифференциально-фазовым искажениям, поэтому искажений при передаче цветов действительно нет. Однако неприятности ожидали ее создателей на резких цветовых переходах. В этих областях возникает паразитное приращение цветовой поднесущей, которое на экране телевизор проявляется как цветные окантовки или же тянущиеся продолжения - «факелы». Обычно после ярких участков изображения окантовка имеет синий цвет, после темных — желтый. Кроме того, в системе SECAM при слабом входном сигнале повышены шумы в канале цветности. Сегодня у телевизоров достаточно высокого класса, оснащенных гребенчатыми фильтрами, эти эффекты практически незаметны.

В целом, если сегодня поставить рядом три телевизора достаточно хорошего класса и подать на них одну и ту же передачу, но в трех разных стандартах (NTSC, PAL, SECAM), то глаз рядового телезрителя не сумеет уловить разницы

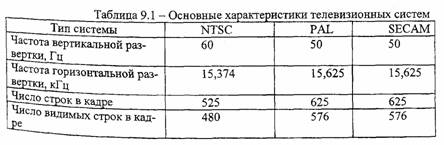

Ниже в таблицах 9.1 и 9.2 приведены основные характеристики телевизионных систем и их модификации.

Напомним, что в России принят стандарт SECAM D/K (первая буква относится к диапазону метровых волн, вторая — дециметровых), во Франции -SECAM E/L, Монако - SECAM C/L, Иране - SECAM В, Германии - PAL B/G Англии - PAL АЛ, Бельгии - PAL В/Н, Бразилии - PAL М/М, Китае - PAL D/K в США, Японии и Тайване - NTSC М/М.

В заключение отметим, что французский и российский SECAM существенно отличаются в модуляции несущего радиосигнала — как по видео, так и по звуку. А на уровне низкочастотных сигналов отличий нет. Основное отличие между SECAM B/G и D/K — в частоте разноса звука от видео. В то же время с точки зрения модуляции радиосигналов отличий между PAL D/K и SECAM D/K нет. Это позволяет использовать телевизионный тюнер, настроенный на PAL D/K, для выделения нашего SECAM из высокочастотного сигнала. Очевидно, что полученный при этом низкочастотный сигнал все же необходимо подавать именно на SECAM-декодер.

9.2. Форматы представления видеосигнала

Низкочастотный телевизионный видеосигнал является композитным, т.е. представляет собой результат сложения яркостного сигнала Y, двух цветовых поднесущих, модулированных сигналами цветности U и V, а также синхроимпульсов, причем частоты цветоразностных сигналов лежат в пределах полосы спектра яркостного сигнала. Но из-за строчной структуры телевизионного разложения в спектральной области все они имеют гребенчатую структуру, расстояния между соответствующими пиками которых равны строчной частоте. При этом частоты поднесущих выбраны так, чтобы спектральные пики сигналов цветности оказались между пиками яркостного сигнала. В результате путем использования специальных гребенчатых фильтров возможно эффективное разделение этих сигналов. Однако, подобные фильтры весьма сложны и дороги, а потому в основном используются в профессиональной аппаратуре высокого разрешения.

В бытовых устройствах ограничиваются более простыми полосовыми фильтрами, заметно снижающими четкость изображений. Так в видеомагнитофонах и камерах классов VHS (Video Home System) и Video-8 используются только композитные видеосигналы, при этом разрешение ограничено 240 телевизионными строками. Кроме того, даже полное использование всех различий сигналов все равно не позволяет идеально разделить их. Поэтому более эффективным оказывается использование не единого композитного сигнала, а двух композитных сигналов Y/C: Y, как и ранее, несет яркостный сигнал и синхроимпульсы, а С (Chrominance) - модулированные цветовые сигналы. Такой сигнал S –Video, используется при записи/воспроизведении в аппаратуре классов S-VHS и Hi-8. Считается, что при этом обеспечивается разрешение в 400 строк

Следующим шагом к повышению качества является переход к компонентному сигналу YUV. Он используется в профессиональной аппаратуре класса Betacam и обеспечивает разрешение до 500 строк. И, наконец, последним в этой череде является RGB-представление, при котором отсутствуют какое – либо кодирование и модуляция, и осуществляется наиболее простая и точная передача сигнала. Однако, в силу вышеуказанных особенностей зрительного восприятия человека, достигаемое здесь повышение качества уже становится визуально несущественным. Поэтому, подобное представление реально используется только в высокоточной научной измерительной аппаратуре.

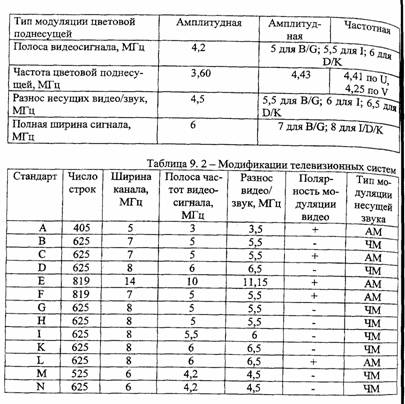

За последние несколько лет появилось большое число различных цифровых форматов представления видеосигнала. Аппаратура, работающая в этих форматах, выпускается рядом фирм — законодателей мод в видеотехнике, такими как Sony, Panasonic, JVC и т. д. Такая аппаратура стала появляться и нашем рынке, хотя пока она слишком дорога для «российского» уровня, особенно для бытового. Приведем сводную таблицу существующих форматов, в том числе и цифровых, к которым вернемся в дальнейшем. Самым «непонятный» в этой таблице столбец это «вид сигнала». Что означают обозначения YUV 4:2:2, YUV 4:1:1 и т. п.? Настало время поговорить о цифровом представлении телевизионного видеосигнала.

9.3. Цифровое представление телевизионного сигнала

По своей массе и производственным мощностям аналоговая вещательная аппаратура все еще преобладает, но очень быстро сдает одну позицию за другой. Как и ожидалось, переход к цифровым вещательным комплексам осуществляется, главным образом, за счет поэтапного встраивания цифрового оборудования в аналоговое окружение. Процесс этот идет повсеместно, но в разных странах темпы перехода различны.

В наиболее развитых странах уже сейчас можно говорить о преобладании цифровой аппаратуры, в некоторых она просто отсутствует. Россию в этом плане, пожалуй, следует отнести к слаборазвитым странам. Бурному внедрению цифровых технологий в наше вещание, естественно, препятствует отсутствие необходимых средств у большинства телевизионных и радиовещательных компаний страны. Тем не менее, дело сдвинуто с мертвой точки и идет с впечатляющим ускорением.

Что предлагают цифровые технологии на разных стадиях подготовки и распространения вещательных программ, как влияют на художественные возможности, о чем следует помнить, работая с цифровой аппаратурой, и чего надо опасаться, особенно в системах с компрессией сигналов? Ответы на все эти вопросы следует знать всем работникам вещательных организаций — инженерно-техническому персоналу и творческим работникам.

Цифровая техника стала постепенно проникать в телевидение в семидесятые годы. Первыми появились цифровые корректоры временных искажений, затем - кадровые синхронизаторы, генераторы специальных эффектов, микшеры, коммутаторы. Но говорить о возможности полномасштабного перехода к цифровому телевидению стали десять лет назад, когда появился первый промышленный цифровой видеомагнитофон, разработанный фирмой Sony. Это - выдающееся событие для телевидения.

Прежде всего, надо отметить, что параметры, характеризующие качество воспроизводимого изображения и звука в цифровом аппарате, превосходили те значения, которые были типичными для аналоговых магнитофонов. Но появление цифровой видеозаписи означало не просто значительное улучшение параметров. Эффект накопления искажений, присущий всем аналоговым системам, например, ограничивает предельно допустимое число перезаписей, которые могут быть сделаны на аналоговом магнитофоне. Так, например, перезапись на магнитофонах формата VHS, без потери качества в пределах нормы, не допускается вообще, формат S-VHS допускает одну - две перезаписи, a Betacam SP три – четыре. А вот цифровые системы практически свободны от эффекта накопления искажений. Если в аналоговом аппарате предельно допустимое число перезаписей исчисляется единицами, то в цифровом видеомагнитофоне визуальное качество изображения не изменяется после десятков перезаписей. А это уже не проста количественное улучшение. Можно сказать, что предельно допустимое количества перезаписей уже практически не ограничивает возможности Издателей телевизионных программ.

Десятилетия основным носителем в системах видеозаписи была магнитная лента. Но сейчас запись на диск завоевывает свое место в видеотехнике. Дисковые системы дороже ленточных, но они обладают весьма важным преимуществом - практически мгновенным (в сравнении с ленточными системами) доступом к любому фрагменту записи. Это создает новые возможности для компоновки и монтажа.

Таким образом, появление цифровой видеозаписи ознаменовало начало кардинальных изменений в технологии производства телевизионных программ. Но цифровая техника порождает и проблемы. Полоса частот цифровых сигналов значительно шире полосы их аналоговых предшественников. Например, полоса частот, занимаемая телевизионным видеосигналом в цифровой форме, составляет сотни мегагерц. Так, при передаче телевизионного сигнала в цифровой форме требуются каналы связи с пропускной способностью до сотен мегабит в секунду. Использование каналов, не вносящих ошибки в цифровой поток и обладающих столь большой пропускной способностью, может оказаться невозможным или экономически невыгодным. При плотностях записи информации, которые приходится использовать, например, в цифровых видеомагнитофонах, ошибки при воспроизведении просто неизбежны. Поэтому сам факт преобразования аналоговых сигналов в цифровую форму еще не гарантирует высокого качества.

Принципиальный способ решения проблем передачи и записи с высокой степенью помехозащищенности был обоснован Шенноном. Он заключается в кодировании сигнала. К системам кодирования в цифровой видеотехнике предъявляются весьма многочисленные и часто противоречивые требования, Поэтому на практике кодирование всегда выполняется в несколько приемов.

Принято выделять следующие основные виды кодирования:

■ кодирования источника информации с целью преобразования сигнала в цифровую форму и его экономное представление путем сжатия или, как часто сворят, компрессии;

■ кодирования с целью обнаружения и исправления ошибок;

■ канального кодирования с целью согласования параметров цифрового сигнала со свойствами канала связи и обеспечения самосинхронизации.

9.3.1. Аналого-цифровое преобразование видеосигналов

Основные приемы преобразования аналогового сигнала в цифровую форму были рассмотрены нами в первой части монографии. Однако автор счел возможным в какой-то степени повторить изложенное, так как здесь мы сосредоточим свое внимание на особенностях оцифровки видеосигналов.

Итак, для преобразования любого аналогового сигнала (звука, изображения) в цифровую форму необходимо выполнить три основные операции: дискретизацию, квантование и кодирование.

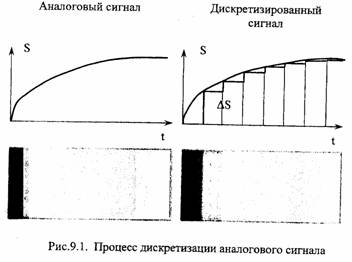

■ Дискретизация - представление непрерывного аналогового сигнала по последовательностью его значений (отсчетов). Эти отсчеты берутся в моменты времени, отделенные друг от друга интервалом, который называется интервалом дискретизации. Величину, обратную интервалу между отсчетами, называют частотой дискретизации. На рис. 9.1. показаны исходный аналоговый сигнал и его дискретизированная версия. Картинки, приведенные под временными диаграммами, получены в предположении, что сигналы являются видеосигналами одной строки, одинаковыми для всего телевизионного растра.

Понятно, что чем меньше интервал дискретизации и, соответственно, выше частота дискретизации, тем меньше различия между исходным сигналом и его дискретизированной копией. Ступенчатая структура дискретизированного сигнала может быть сглажена с помощью фильтра нижних частот. Таким образом и осуществляется восстановление аналогового сигнала из дискретизированного. Но восстановление будет точным только в том случае, если частота дискретизации по крайней мере в 2 раза превышает ширину полосы частот исходного сигнала (это условие определяется известной Котельникова) Если это условие не выполняется, то дискретизация сопровождается необратимыми искажениями. Дело в том, что в результате дискретизации в частотном спектре сигнала появляются дополнительные компоненты, располагающиеся вокруг гармоник частоты дискретизации в диапазоне, равном удвоенной ширине спектра исходного аналогового сигнала. Если максимальная частота в частотном спектре аналогового сигнала превышает половину частоты дискретизации, то дополнительные компоненты попадают в полосу частот исходного аналогового сигнала. В этом случае уже нельзя восстановить исходный сигнал без искажений. Теория дискретизации приведена во многих книгах.

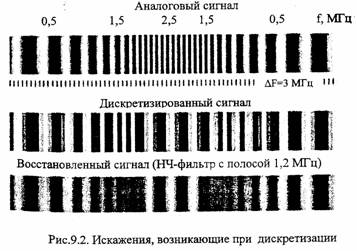

Предположим, что частота видеосигнала ТВ строки сначала увеличивается от 0,5 МГц до 2,5 МГц, а затем уменьшается до 0,5 МГц. Этот сигнал дискретизируется с частотой 3 МГц. На рис. 9.2 последовательно приведены изображения: исходный аналоговый сигнал, дискретизированный сигнал, восставленный после дискретизации аналоговый сигнал. Восстанавливающий фильтр нижних частот имеет полосу пропускания 1,2 МГц. Как видно, низкочастотные компоненты (меньше 1 МГц) восстанавливаются без искажений. Сигнал с частотой 1,5 МГц исчезает и превращается в относительно ровное поле. Сигнал с частотой 2,5 МГц после восстановления превратился в сигнал с частотой 0,5 МГц (это разность между частотой дискретизации 3 МГц и частотой исходного сигнала 2,5 МГц).

Пример искажений дискретизации приведен на рис. 9.2.

Эти диаграммы-картинки иллюстрируют искажения, связанные с недостаточно высокой частотой пространственной дискретизации изображения. Если объект телевизионной съемки представляет собой очень быстро движущийся или, например, вращающийся предмет, то могут возникать и искажения дискретизации во временной области.

Если потребовать, чтобы в процессе дискретизации не возникало искажений ТВ сигнала с граничной частотой, например, 6 МГц, то частота дискретизации должна быть не меньше 12 МГц. Однако, чем ближе частота дискретизации к удвоенной граничной частоте сигнала, тем труднее создать фильтр нижних частот, который используется при восстановлении, а также при предварительной фильтрации исходного аналогового сигнала. Это объясняется тем, что при приближении частоты дискретизации к удвоенной граничной частоте дискретизируемого сигнала, предъявляются все более жесткие требования к частотных характеристик осстанавливающих фильтров - она все точнее должна соответствовать прямоугольной характеристике. Следует подчеркнуть, что фильтр с прямоугольной характеристикой не может быть реализован физически. Такой фильтр, как показывает теория, должен вносить бесконечно большую задержку в пропускаемый сигнал. Поэтому на практике всегда существует некоторый интервал между удвоенной граничной частотой исходного сигнала и частотой дискретизации.

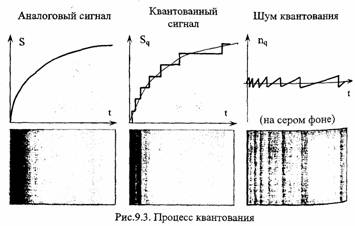

■ Квантование представляет собой замену текущей величины отсчета сигнала ближайшим значением из набора фиксированных величин - уровней квантования. Другими словами, квантование - это округление величины отсчета. Уровни квантования делят весь диапазон возможного изменения значений сигнала на конечное число интервалов — шагов квантования. Расположение уровней квантования обусловлено шкалой квантования. Используются как равно мерные, так и неравномерные шкалы. На рис. 9.3 показаны исходный аналоге вый сигнал и его квантованная версия, полученная с использованием равно мерной шкалы квантования, а также соответствующие сигналам изображения.

Искажения сигнала, возникающие в процессе квантования, называют шумом квантования. При аппаратной оценке шума вычисляют разность между исходным сигналом и его квантованной копией, а в качестве объективных показателей шума принимают, например, среднеквадратичное значение этой разности. Временная диаграмма и изображение шума квантования также показаны на рис. 9.3 (изображение шума квантования показано на сером фоне). В отличие от флуктуационных шумов шум квантования коррелирован с сигналом, поэтому шум квантования не может быть устранен последующей фильтрацией. Шум квантования убывает с увеличением числа уровней квантования.

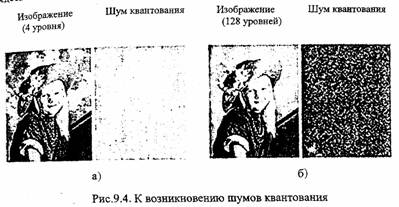

На рис. 9.4, а показано изображение, квантованное на 4 уровня, и соответствующий такому числу уровней шум квантования, в котором можно разглядеть исходного изображения.

Изображение, показанное на рис. 9.4, б, получено с использованием 128 уровней. При таком уже сравнительно большом числе уровней шум квантования похож на обычный флуктуационный шум. Уровень шума уменьшился, поэтому пришлось для показа картинки шума квантования увеличить его масштаб, чтобы шум был заметен. Еще несколько лет назад вполне достаточным казалось использовать 256 уровней для квантования телевизионного видеосигнала. Сейчас считается нормой квантовать видеосигнал на 1024 уровня. Число Уровней квантования при формировании цифрового звукового сигнала намного больше: от десятков тысяч до миллионов.

■ Цифровое кодирование. Квантованный сигнал, в отличие от исходного аналогового, может принимать только конечное число значений. Это позволяет представить его в пределах каждого интервала дискретизации числом, равным порядковому номеру уровня квантования. В свою очередь это число можно выразить комбинацией некоторых знаков или символов. Совокупность знаков (символов) и система правил, при помощи которых данные представляются в виде набора символов, называют кодом. Конечная последовательность кодовых символов называется кодовым словом. Квантованный сигнал можно преобразовать в последовательность кодовых слов. Эта операция и называется кодированием. Каждое кодовое слово передается в пределах одного интервала дискретизации. Для кодирования сигналов звука и изображения широко применяют двоичный код.

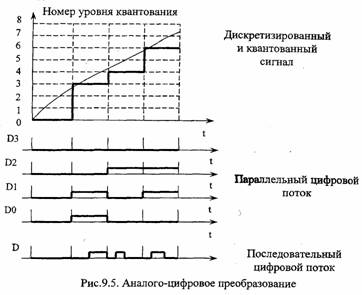

Кодовые слова можно передавать в параллельной или последовательной формах (рис. 9.5). Для передачи в параллельной форме надо использовать n линий связи (в примере, показанном на рисунке, n = 4). Символы кодового слова одновременно передаются по линиям в пределах интервала дискретизации. Для передачи в последовательной форме интервал дискретизации надо разделить на n подинтервалов — тактов. В этом случае символы слова передаются последовательно по одной линии, причем на передачу одного символа слова отводится один такт. Каждый символ слова передается с помощью одного или нескольких дискретных сигналов - импульсов. Преобразование аналогового сигнала в последовательность кодовых слов, поэтому часто называют импульсно – кодовой модуляцией. Форма представления слов определенными сигналами определяется форматом кода. Можно, например, устанавливать в пределах такта высокий уровень сигнала, если в данном такте передается двоичный символ 1, и низкий - если передается двоичный символ 0 (такой способ представления, показания» на рис. 9.5, называют форматом БВН - Без Возвращения к Нулю). В пример рис. 9.5 используются четырехразрядные двоичные слова (это позволяет иметь 16 уровней квантования). В параллельном цифровом потоке по каждой линии в передалах дискретизации передается 1 бит четырехразрядного слова. В последовательном потоке интервал дискретизации делится на 4 такта, в которых передается

( начиная со старшего) биты четырехразрядного слова

9 3.2 Цифровое представление компонентного видеосигнала

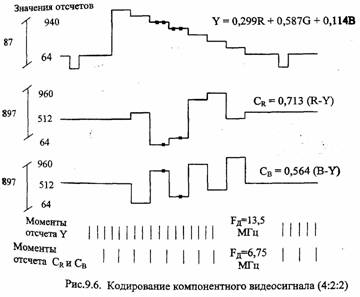

Компонентный телевизионный видеосигнал может быть представлен в форме в соответствии с Рекомендацией ITTJ-R 601. Эта рекомендация раздельной дискретизации, квантования и кодирования цветоразностных сигналов R-Y (Сr) и B-Y (Сb). Частота дискретизации для яркостного сигнала Y установлена равной 13,5 МГц, цветоразностных сигналов — 6,75 МГц, то есть частота дискретизации яркостного сигнала в 2 раза больше частоты дискретизации цветоразностных сигналов. Если взять, как принято, в качестве условной (базовой для иерархии цифровых стандартов) единицы частоту 3,375 МГц, то частоты дискретизации яркостного и двух цветоразностных сигналов будут находиться в соотношении 4-2-2, которое и дает часто используемое название стандарта.

При таких значениях частот дискретизации можно практически преобразовать без искажений в цифровую форму сигнал яркости в полосе до 5,75 МГц, а цветоразностные сигналы - в полосе до 2,75 МГц (надо помнить о защитном интервале между граничной частотой сигнала и половиной частоты дискретизации). Стандарт 4:2:2 используется в качестве базового при оценке других вариантов дискретизации, и на значение 5,75 МГц часто ссылаются как на границу полной полосы ТВ сигнала.

Рисунок 9.6 показывает дискретизацию компонентного телевизионного сигнала на примере сигнала цветных полос. Длина кодового слова – 10 двоичных разрядов — битов (в первоначальном варианте — 8 битов), что позволяет перенумеровать 1024 уровня квантования. Однако числа 0..3 и 1020..1023 резервируются для цифровых синхронизирующих сигналов. Для квантования яркостного сигнала выделяется 877 уровней (значение черного в видеосигнале соответствует уровню квантования 64, а номинальное значение белого — уровни-940). Для квантования цветоразностных сигналов выделяется 897 уровней, причем нулевому значению аналогового сигнала соответствует уровень квантования 512.

Приведенные диапазоны уровней квантования часто используются при сравнении с другими вариантами квантования. В этом случае на них часто ссылаются как на показатели динамического диапазона или полного разрешения по уровню сигнала, поскольку число уровней квантования определяет шум квантования и, соответственно, динамический диапазон. В этом же смысле иногда говорят о 10-битном разрешении.

Частоты дискретизации представляют гармоники строчной частоты, что обеспечивает неподвижную ортогональную структуру отсчетов ТВ изображения (рис. 9.7).

Рис.9.7. Структура дискретизации при кодировании компонентного видеосигнала (4:2:2)

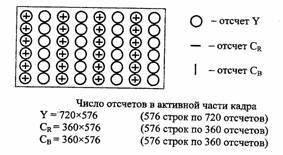

Величинам 13,5 и 6,75 МГц кратна, как частота строчной развертки стандарта телевизионного разложения 625/50, так и частота развертки стандарт 525/60. Собственно, выбор в качестве базовой именно частоты 3,375 МГц во многом связан с соображениями кратности с частотами строчной развертки двух мировых стандартов разложения. Это важно потому, что позволило ввести единый мировой стандарт цифрового кодирования компонентного видеосигнала, при котором в активной части строки содержится 720 отсчетов яркостного сигнала, и по 360 — каждого цветоразностного. Различие в системах 625/50 и сигнала и 525/60 заключается в разном числе строк и несколько отличающейся длительности интервала гашения. Полная скорость передачи цифрового компонентного видеосигнала составляет 10х3,5+10x6,75+10x6,75=270 Мбит/с.

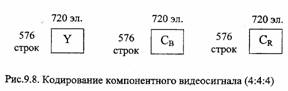

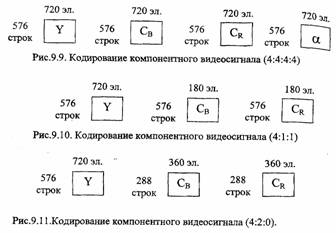

Существует и другие форматы представления компонентного сигнала в цифровом виде. Кодирование по стандарту 4:4:4 предполагает использование частоты 13,5 МГц для всех компонентов: R, G, В или Y, Сr, Сb (рис. 9.8). Это означает, что все компоненты передаются в полной полосе частот. Для каждого компонента в активной части кадра оцифровывается 576 строк по 720 элементов Скорость цифрового потока при 10-битовом слове составляет 405 Мбит/с.

Формат 4:4:4:4 описывает кодирование четырех сигналов (рис.9.9), три из которых являются компонентами видеосигнала (R, G, В или Y, Сr, Сb), а четвертый (альфа-канал) несет информацию об обработке сигнала, например, о прозрачности изображения переднего плана при наложении нескольких изображений. Дополнительным четвертым сигналом может также быть сигнал яркости Y в дополнении к сигналам основных цветов R, G, В. Частота дискретизации всех сигналов — 13,5 МГц, т.е. все сигналы передаются в полной полосе частот. Скорость передачи данных при 10 битах на слово равна 540 Мбит/с.

Формат 4:1:1 предлагает двукратное уменьшение частоты дискретизации цветоразностных сигналов (в сравнении со стандартом 4:2:2). Яркостной сигнал Y дискретизируется с частотой 13,5 МГц, а цветоразностные (Сr и Сb) - 3,375 Ц. Это означает и двукратное уменьшение горизонтального разрешения в Цвете. В активной части кадра 576 строк, каждая из которых содержит 720 элементов сигнала яркости и по 180 - цветоразностных сигналов (рис. 9.10). Формат 4:2:0 предлагает изображение, в котором яркостная компонента Y содержит в активной части кадра 576 строк по 720 отсчетов, а цветоразностные компоненты Сr и Сb – 288 строк по 360 отсчетов (рис. 9.11)

Варианты кодирования 4:1:1 и 4:2:0 характеризуются одинаковой скоростью передачи данных – 202,5 Мбит/с для длины кодового слова в 10 бит и 162 Мбит/с – для 8 бит на слова. Если передавать только активную часть изображения (без обратного хода луча), то величина цифрового потока при 8 битах на слова составит 124 Мбит/с. Цифровые сигналы этих двух форматов могут быть из получены сигналов стандарта 4:2:2 путем предварительной обработки и децимации (прореживания отсчетов) с целью сокращения скорости потока. Формат 4:1:1 оказывается более удобным для систем со стандартом разложения 525/60, а формат 4:2:0 — для систем 625/50. Это связано с тем, что потеря вертикальной четкости более заметна в системе с меньшим числом строк (525/60), а потеря горизонтальной четкости более заметна в системе 625/50.

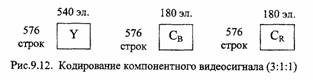

Находит применение также формат 3:1:1, в котором уменьшено (в сравнении с 4:2:2) горизонтальное разрешение и для яркостной компоненты (с 720 до 540), и для цветоразностных (с 360 до 180). Активная часть кадра содержит 576 строк с 540 отсчетами яркостной компоненты и 180 отсчетами для цветоразностных (рис. 9.12). Скорость передачи данных формата 3:1:1 составляет 135 Мбит/с при 8 битах на один отсчет. Для значительного сокращения скорости потока (например, в CD-ROM приложениях) разрешение яркостной компоненты снижается примерно в 2 раза по вертикали и по горизонтали, а цветоразностных — в 4 раза по вертикали и в 2 раза по горизонтали (в сравнении со стандартом 4:2:2).

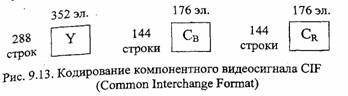

Такой вид представления описывается форматом CIF (Common Interchange Format). Один кадр этого формата содержит в активной части 288 строк по 352 отсчета для яркостной компоненты и 144 строки по 176 отсчетов для цветоразностных компонент (рис. 9.13). При передаче только активной части изображения скорость потока составляет около 30 Мбит/с при 8 битах на отсчет

9.3.3. Цифровое представление композитного видеосигнала

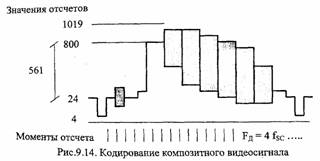

Композитный сигнал по системам PAL и NTSC дискретизируется с частотой 4fsc, равной четвертой гармонике цветовой поднесущей. Рис. 9.14 иллюстрирует дискретизацию и квантование композитного телевизионного видеосигнала (в качестве сигнала показан сигнал цветных полос). В системе NTSC строка содержит 910 отсчетов, из которых 768 образуют активную часть цифровой строки. В системе PAL на интервал аналоговой строки приходится нецелое число отсчетов с частотой 4fsc. Это обусловлено тем, что в системе PAL помимо четвертьстрочного сдвига используется дополнительный сдвиг частоты поднесущей на частоту кадров (25 Гц).

Для сохранения непрерывного цифрового потока отсчетов, следующих с постояной частотой 4fsc, в системе PAL длительность цифровой строки принята неравной длительности аналоговой строки. Все строки поля (за исключением двух) содержат по 1135 отсчетов, а две - по 1137. Длина кодового слова – 10 бит. Необходимость цифрового кодирования фронта и среза синхроимпульсов композитного аналогового сигнала приводит к тому, что для диапазона от

номинальной величины черного до номинального белого выделяется примерно на 30% меньше уровней квантования, чем для сигнала в компонентной форме. Скорость передачи данных для цифрового сигнала в системе NTSC составляет 143 Мбит/с, а в системе PAL - 177 Мбит/с.

9.3.4. Цифровое представление сигналов звукового сопровождения

Несколько слов надо сказать о цифровом представлении звукового сигнал, так как многие цифровые устройства обработки видеосигналов имеют и звуковую часть, необходимую для синхронной обработки звука и изображения. Oсобенно это относится к нелинейным видеомонтажным платам и системам.

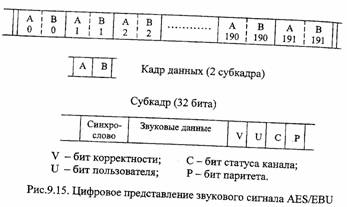

Для передачи звукового сопровождения в телевидении применяются цифровые сигналы стандарта AES/EBU. В соответствии с этим стандартом при аналого-цифровом преобразовании звука используется импульсно-кодовая модуляция с линейной шкалой квантования, причем на один отсчет для собственно но звуковых данных отводится до 24 бит (рис. 9.15). Форма представления кодовых слов - последовательная. К каждому слову звуковых данных добавляются биты корректности отсчета V, состояния канала С, данных пользователя U. Эта группа из 27 бит, дополненная битом четного паритета Р и синхрословом из 4 бит, образует субкадр из 32 бит.

Стандарт поддерживает два звуковых сигнала (например, два моно или один стереоканал), из отсчетов которых формируется кадр. 192 последовательных кадра объединяются в блок данных. Объединение в блок значимо лишь постольку, поскольку в пределах блока с помощью битов С передается информация, например, о характере сигнала (моно или стерео), о внесенных предискажениях. В пределах блока группируется и информация пользователя. Стандарт AES/EBU допускает ряд частот дискретизации, из которых наиболее удобной для телевидения является частота 48 кГц, при которой длительность блока составляет 4 мс. При этом устанавливается простое соотношение между частотой дискретизации звука и частотой видеокадров, что упрощает синхронизацию я передачу цифровых сигналов видео и звука по одной линии связи. Скорость передачи звуковых данных при частоте 48 кГц составляет 3,072 Мбит/с.

ГЛАВА 10. СЖАТИЕ ВИДЕОИНФОРМАЦИИ [23, 26, 50-55]

Основной сложностью при записи цифрового видео и при его передаче по каналам связи является большой объем телевизионного сигнала. Проведем расчет, который покажет, какой же объем будет иметь обычный двухчасовой фильм в разрешении 640x480 с частотой смены кадров 25 Гц. Пусть каждая точка принадлежит стандартной компьютерной палитре RGB из 16 миллионов цветов. 640х480х3=900 кбайт – размер одного кадра, 22500 кбайт - размер одной секунды видео, 154 Гбайт!!! - размер всего фильма. Ясно, что такие огромные объемы информации хранить и передавать очень сложно. Так, если мы хотим поместить фильм из примера на компакт-диск объемом в 650 Мб, то нам понадобятся 243 диска! Поэтому сразу же с появлением цифрового видео остро встал о компрессии видеоданных. Причем эта компрессия должна быть очень сильной. Напомню, что звук удается сжать только раз в 10...20, даже используя самые совершенные алгоритмы.

Осуществить компрессию ТВ-сигнала позволяет присущая ему избыточность. В общем случае большая часть изображения любого ТВ-кадра обычно приходится на участки, имеющие постоянную или мало меняющуюся в пространстве яркость, а резкие световые переходы и детали малых размеров занимают небольшую долю площади изображения. Коэффициент корреляции соседних элементов изображения, описывающий статистическую связь между яркостями этих элементов, близок к нуля. Зная яркость одного элемента, можно с высокой степенью вероятности предсказать яркость соседнего. Такого рода избыточность можно назвать пространственной избыточностью изображения.

Изображения соседних кадров в телевидении обычно очень похожи друг на друга, даже при показе движущихся объектов. Переходы от сюжета к сюжету встречаются редко. Межкадровая разность на значительной части площади изображения обычно близка к нулю. Зная распределение яркости в одном кадре, можно с высокой степенью уверенности предсказать распределение яркости следующего кадра. Эта предсказуемость указывает на временную избыточность изображения.

В телевидении различают статистическую избыточность, избыточность восприятию, структурную и спектральную избыточность. По теории вероятностей избыточность является следствием определенных корреляционных связей. Корреляция означает, что некоторый элемент изображения более или менее существенно зависит от соседей в пространстве и во времени. Под статистической избыточностью понимают корреляционные связи между соседними (по вертикали горизонтали) отсчетами ТВ-сигнала. Необходимо подчеркнуть, что снижение избыточности в этом случае до определенных пределов обратимо. Примером такого «беспроигрышного» кодирования служит предсказание на основе ДКП. Можно назвать и другие разностные методы.

Избыточность по восприятию связана с особенностями зрения человека Например, цветовое разрешение нашего зрения ниже яркостного. Эта особенность учтена во всех стандартных аналоговых системах цветового кодирование. В системах вещательного телевидения NTSC, PAL и SECAM цветовое разрешение существенно понижено по отношению к яркостному. То же самое зафиксировано в цифровом стандарте 4:2:2, где, по определению, две цветоразностные компоненты представлены таким же по объему информационным массивом, что и один яркостный сигнал.

Учитывая эту особенность нашего зрения по восприятию мелких деталей цветного изображения, можно в несколько раз сократить полосу частот при передаче и кодировании сигналов цветности.

Структурная избыточность - итог особенностей стандарта разложения или, по иному, преобразования изображения в ТВ-сигнал. В нем, например, периодически передаются неизменные по форме элементы сигнала: гасящие пульсы строк и полей. В цифровом ТВ-сигнале нет необходимости передав эти импульсы по каналу связи, так как они могут быть восстановлены в декодере по опорным сигналам синхронизации. В цифровом телевидении достаток передавать только активную часть изображения. В цифровом стандарте 4:2:2 при 10 битах на отсчет устранение из состава цифрового ТВ-сигнала гасящих импульсов строк и полей сокращает скорость передачи данных с 270 Мбит/с 207 Мбит/с, то есть примерно на 23%.

Спектральная избыточность проявляется как результат излишка высок частоты дискретизации. В частности, принятая ортогональная структура дискретизации ТВ-изображения в общем случае не является оптимальной в частотном пространстве. Можно сократить передаваемый цифровой поток, если преобразовать используемую структуру дискретизации в другую, которая характеризуется меньшим числом отсчетов в кадре, например, от формата 4:2:2 перейти к формату 4:2:0 или 4:2:1. Используя интерполяцию и передискретизацию определенным образом выбранных групп отсчетов ТВ-сигнала, можно, принципе, видоизменить спектральный состав и снизить частоту дискретизации. Такая обработка обычно необратима и, как правило, ведет к некоторому снижению качества восстановленного ТВ-изображения за счет уменьшения его разрешения.

Избыточность телевизионного сигнала положена в основу разработки методов сжатия, получивших название MPEG-сжатия.

Напомним, что аббревиатура MPEG представляет собой сокращение от названия специальной экспертной группы Moving Picture Coding Experts Group (дословно - «Группа экспертов по кодированию подвижных изображений»), образованной Международной организацией по стандартизации (International Organization for Standartization - ISO) и Международной электротехнической комиссией (International Electro-Technical Commission - IEC) в январе 1988 года. Немногочисленная вначале группа молодых специалистов все последущие годы непрерывно росла. Сейчас в ее работе принимают активное участие более 300 ведущих экспертов из различных академических учреждений и более чем из 200 компаний, включая, такие известные, как Fujitsu, General Instrument, Matsushita, Mitsubishi, Philips, Scientific Atlanta, Sony, Samsung Electronics и др.

К настоящем моменту группой создана уже целая серия стандартов: MPEG – 1, MPEG – 2, MPEG – 4, MPEG – 7, а с июня стоящем 2000 г. ведутся работы над еще одним стандартом – MPEG – 21 – Multimedia Framework (Система мультимедийных средств)

Задаче, решаемые этой группой, являются очень современными и направлены на создание целого комплекса технологий цифрового представления, сжатия, хранения, передачи и обработки аудио- и видеоинформации, однако сами работы в этой области были начаты значительно раньше.

По сути, теория решения задач цифрового отображения и сжатия аналоговой информации была обоснована еще в трудах Н. Винера, К. Шеннона, А. Колмогорова В. Котельникова в 30-40-е годы двадцатого века. Стройная теория цифровой компрессии видеосигналов была изложена в 1965 г. Д. Лебедевым и И. Цукерманом в их книге «Телевидение и теория информации», а все основные методы обработки ТВ – сигналов, реализовывавшиеся до настоящего времени, нашли свое отражение в труде коллектива авторов «Цифровое телевидение», вышедшего в нашей стране в 1980 г. Но еще более десяти лет потребовалось для того, чтобы эти идеи и результаты многочисленных научных исследований приобрели лаконичный вид международных стандартов.

Спецификация стандарта MPEG-1, описывающая технологию информационного сжатия для хранения и передачи цифровых данных подвижного изображения и звука по сравнительно низкоскоростным каналам связи (до 1-3 Мбит/с), официально была выпущена в ноябре 1992 года. Однако использованный в ней метод сжатия кадров видеоинформации был разработан несколько раньше в рамках другой группы - JPEG, занимавшейся вопросами компьютерной обработки неподвижных фотографических изображений.

Фотографическое начало - стандарт JPEG. Объединенная группа экспертов по компьютерной обработке фотографических изображений - Joint Photographic Expert Group (JPEG) - была образована совместно Международным союзом электросвязи (International Telecommunications Union - ITU) и ISO в 1986 году. Ее задачей являлась разработка стандарта представления неподвижных цифровых изображений. Первую спецификацию такого стандарта группа опубликовала в 1991 году. Тремя годами позже - в 1994 году - эта спецификация была признана индустриальным стандартом кодирования неподвижных изображений.

Алгоритм обработки. Одной из основных целей, стоявших перед группой JPEG, была разработка компактного метода представления цветных неподвижных изображений в цифровой форме. При этом, учитывая весьма большие исходные цифровых изображений, целесообразно было найти методы компрессии, обеспечивающие сжатие массивов данных не менее чем в десятки раз

В процессе своей работы группа JPEG обобщила более чем полувековой следований опыт исследований множества специалистов в области человеческого зрения, телевидения, компьютерной графики и др. В результате этого была предложена, технология, использующая так называемое сжатие «с потерями». Его суть заключается в том, что восстановленный после сжатия цифровой массив в не полностью соответствует исходному, однако визуально такое изображение оказывается практически неотличимым от первоначального. Другими словами, при подобной обработке теряются те детали изображения, которые все равно не воспринимаются зрительной системой человека. Достоинством же сжатия с потерями является достижение очень высоких степеней компрессии данных (до 25 раз и более), против всего 2-х кратного сжатия, даваемого на типичных изображениях даже наиболее эффективными алгоритмами компрессии без потери информации.

Алгоритм сжатия JPEG состоит из ряда следующих друг за другом этап обработки цифрового массива, описывающего цветное изображение.

На первом этапе исходное изображение делится на макроблоки размер 16x16 точек изображения (пикселей), которые далее будут обрабатываться по отдельности. Данная операция позволяет на следующих этапах существенно снизить общий объем вычислений по сравнению со случаем обработки вся изображения как единого массива. Выигрыш в объеме вычислений прямо пропорционален числу макроблоков, на которые делится изображение, но выбор их размера менее 8x8 пикселей на реальных изображениях приводит к снижению достижимой степени сжатия.

На втором этапе осуществляется переход к более подходящему для сжатия способу представления цветов. Как известно, в компьютерной графике цвета обычно задаются в трехмерной системе координат и описываются как комбинации трех равноправных «основных» цветов: красного (R), зеленого (G) и синего (В). Однако особенностям человеческого зрения более соответствует другая система координат: YCbCr, где Y — сигнал яркости, а Сb и Сr - насыщенность синего и красного тонов. Данная совокупность параметров без каких – либо искажений описывает исходное цветное изображение, но при этом делит его на две части: черно-белую (сигнал Y) и цветную (Сb и Сr). Именно таким образом в глазу человека и воспринимаются цветные изображения с помощью двух типов сенсоров: палочек, ориентированных на яркостную составляющую и колбочек — анализирующих цвет. Число палочек в глазу приблизительно в 20 раз превышает число колбочек, что обусловливает его значительно большую чувствительность к перепадам яркости в изображении, чем цвета. А отсюда возникает возможность передачи цветовой информации с меньшей детальностью без ущерба для восприятия итогового изображения. Надо отметить, что именно подобный метод передачи информации использован и в широко распространенных системах цветного телевидения NTSC, PAL и SECAM.

На третьем этапе обработки производится так называемое «прореживание», использующее описанную выше особенность человеческого. Для этого, в полученных на предыдущем этапе матрицах значений насыщенности» синего и красного цветов отбрасываются все четные столбцы и строки, в результате чего исходные макроблоки размером 16x16 отсчетов превращаются в блоки 8x8. Данная операция является первой, при которой вносятся необратимые изменения происходит потеря сразу 75% информации о распределении цветов в изображении, однако с позиций заметности для глаза такое сокращение объема данных оказывается вполне допустимым.

Матрица отсчетов яркости на этом этапе остается без изменений, но для обеспечения дальнейшего единообразия в обработке исходный макроблок из 16x16 отсчетов делится на четыре части, также образуя блоки размером 8x8.

На следующем этапе обработки в стандарте JPEG использован чисто математический прием под названием «Дискретное косинусное преобразование» (Discrete Cosine Transform – DCT), предложенный В. Ченом в 1981 году. По сути, этот метод сходен с более известным двумерным дискретным преобразованием Фурье и отличается от него только используемыми базисными функциями. Достоинством DCT по сравнению с другими аналогичными ортогональными преобразованиями (синусным, Фурье, Адамара, Хаара и др.) является быстрая сходимость ряда, что обеспечивает меньшую погрешность ошибки преобразования.

Основу для применения DCT составляет тот факт, что в реальных изображениях величины соседних отсчетов вдоль строки, а также в соседних строках – очень похожи друг на друга (коэффициент корреляции между ними составляет 0,9...0,98). Другими словами, полученные на предыдущем этапе обработки матрицы состоят из отсчетов, почти равных между собой по величине, а DCT преобразует информацию о величинах отсчетов в информацию о скорости изменения этих величин. В результате этого исходная матрица отсчетов превращается в такую же по размерам матрицу частотных коэффициентов, которые уже не имеют такой прямой геометрической связи с положением отсчетов сигнала в изображении. Они могут рассматриваться как двумерный спектр скоростей изменения изображения в горизонтальном и вертикальном направлениях. Достоинством такой формы записи является то, что для реальных изображений большинство значащих членов в новой матрице оказывается сгруппировано в левом верхнем углу (область малых скоростей изменения величин отсчетов в изображении), а правая нижняя часть матрицы (область больших скоростей) содержит члены с малыми значениями или вообще нулевые.

Дискретное косинусное преобразование является обратимым и по новой матрице может быть полностью (с точностью до погрешности преобразования, которой на практике в большинстве случаев можно вообще пренебречь) восстановлена исходная. Но полученная новая форма записи информации об изображении позволяет в дальнейшем существенно сократить итоговый объем данных.

Одной из предпосылок Для этого является то, что для правильного восприятия большинства реальных фотографических и телевизионных изображений характеризующихся мягкими переходами яркости и смены оттенков, глазу оказываются значительно важнее низкочастотные компоненты DCT, нежели высокочастотные. Это свойство глаза используется на следующем этапе обработки, где применяется неравномерное квантование частотных коэффициентов.

При этом, низкочастотные компоненты квантуются с большей детальностью, а высокочастотные – с меньшей. Применение более грубого квантования высокочастотных компонент DCT матрицы позволяет описать изображение меньшим общим количеством бит. Кроме этого, частотные коэффициенты, значения которых не превышают некоторую заданную пороговую величину, вообще принимаются равными нулю. Подобная потеря высокочастотных компонент матрицы DCT (при задании очень большой величины порога) может приводить к появлению искажений в восстановленном изображении, наиболее сильно проявляющихся в так называемом «дрожании» линий на границах резких переходов яркости и цвета.

Другой вид искажений, связанный с процессом квантования, обусловлен тем, что округление частотных коэффициентов в разных матрицах производятся независимо, поэтому в восстановленном изображении значения яркости и цветового тона на границах таких «квадратиков» могут немного не совпадать и проявляться в мозаичности получаемого изображения.

Дальнейшие операции алгоритма JPEG не связаны с потерями информации и включают: последовательное считывание в зигзагообразном порядке квантованных значений матрицы DCT, а также два этапа энтропийного сжатия использующих метод кодирования длин серий и код Хаффмана. Необходимо отметить, что именно на этом этапе и обеспечивается основное сжатие информации, но оно оказывается возможным только благодаря достигнутой на предыдущих этапах «сортировке» исходных данных.

Суть зигзагообразного считывания заключается в том, что матрица частотных коэффициентов преобразуется в последовательный код. При этом считывание членов матрицы начинается с левого верхнего угла и далее последовательно идет по диагоналям до правого нижнего угла. В результате этого все значащие члены матрицы группируются в начале полученной кодовой группы а в ее конце, как правило, образуется непрерывная последовательность нулей. Здесь возникает первая возможность для сжатия кода: все нули в конце могут быть просто отброшены, а при декодировании — дописаны, исходя из того, что общее число членов в кодовой группе должно быть равно 64. Все другие непрерывные последовательности одинаковых величин сжимаются стандартным методом кодирования длин серий, когда сама последовательность величин заменяется всего двумя параметрами: значением величины и числом членов в последовательности. На последнем этапе все полученные величины кодируются кодом Хаффмана, относящимся к группе статистических кодов. Его суть заключается в том, что наиболее часто встречающимся величинам присваиваются самые короткие кодовые последовательности, а более редким – длинные. В итоге среднее число бит, приходящееся на один кодируемый символ, оказывается минимальным, приближающимся к энтропии источника, что обеспечив наиболее компактную форму отображения информации.

При декомпрессии вся описанная последовательность операций выполняется в обратном порядке.

Приведение столь подробного описания алгоритма сжатия, реализованного в стандарта JPEG, целесообразно потому, что этот мощный алгоритм в настоящее время используется уже в целом ряде различных технологий передачи, обработки и хранения цифровых изображений.

JPEG – 2000 MJPEG и другие. В 1998 году из состава группы JPEG выделилась группа JBIG (Joint Bi-level Image Group), разрабатывающая стандарты представления графической информации для специфических применений. Разработанные этой группой алгоритмы G3 и G4 для факсимильной передачи псевдополутоновых и цветных изображений стали частью стандартных протоколов факсимильной связи, утвержденных ITU. А тем временем группа JPEG разработала новую версию стандарта JPEG-2000, нацеленную на решение проблем, связанных с компромиссом между коэффициентом сжатия информации и качеством изображения.

Технология сжатия JPEG стала применяться и для передачи подвижных изображений. Так, например, формат Motion JPEG (или просто MJPEG) описывает цифровой видеосигнал, представляющий собой последовательность изображений, сжатых по стандарту JPEG. Алгоритм сжатия JPEG также нашел свое отражение и в современных стандартах видеоконференцсвязи: Н.261, Н 263 Н 320 Н.323, Н.324. Но главное — JPEG – сжатие является основой алгоритма для обработки сигналов изображения в стандартах MPEG.

10.2. Стандарт кодирования видеоинформации MPEG-1

Работы над стандартом MPEG-1 были начаты в 1988 году. Первоначально этот стандарт предназначался для записи синхронизированных между собой видеоизображения и звукового сопровождения на существующие в то время цифровых носителях, таких как CD-ROM диски, DAT-кассеты и т. д., с максимальной скоростью передачи данных порядка 1,5 Мбит/с. Кроме этого, этот стандарт должен был обеспечивать произвольный доступ к информации и возможность ее просмотра в обоих направлениях. В дальнейшем MPEG-1 получил достаточно широкое распространение во многом благодаря дискам VideoCD.

Первый вариант спецификации MPEG-1 был опубликован в январе 1992 года, а в 1993 году MPEG-1 был принят в качестве стандарта ISO/IEC 11172-2. Несколько позже были разработаны и стандартизированы сопутствующие спецификации для аудиоданных – MPEG-1 Audio Layer I, Layer II и Layer III (ISO/IEC 11172-3). Последним шагом была разработка протокола синхронизации пакетирования аудио- и видеоданных в формате MPEG-1.

При разработке стандарта были приняты следующие ограничения, определившие его область применения:

■ размер изображения по горизонтали < 768 пикселей;

■ размер изображения по вертикали < 576 строк;

■ число макроблоков < 396;

■ частота кадров < 30 Гц;

■ развертка прогрессивная;

■ скорость цифрового потока < 1,856 Мбит/с.

На первый взгляд может показаться, что нет особых препятствий пользованию MPEG-1 для кодирования сигналов вещательного телевидения – число строк и элементов в строке даже выше, чем требуется для изображения стандартной четкости. Напомним, что это 720x576 или 720x480 пикселей, в зависимости от стандарта разложения. Ограничивающим параметром оказывается, как ни странно, число макроблоков в видеокадре. Для обработки стандартного телевизионного сигнала надо иметь (720:16) х (576:16) = 1620 макроблоков/кадр, а стандарт предусматривает только 396, что соответствует формату разложения не выше CIF (352 х 288 пикселей). Второе препятствие – отсутствие чересстрочной развертки, принятой сегодня во всех телевизионных системах стандартного качества.

В связи с жестким ограничением максимальной скорости цифрового , потока, типовым видеоформатом для MPEG-1 явился Common Intermediate Format (CIF), содержащий 240 строк по 352 точки в строке при 30 кадрах в секунду, или 288 строк и 352 точки в строке — при 25 кадрах. Подобное изображение приблизительно соответствует качеству картинки бытовой видеозаписи формата VHS и имеет разрешение в четыре раза ниже стандартного изображения вещательного телевидения. Для согласования размеров изображения со стандартным, алгоритм сжатия MPEG-1 предусматривает процедуру «прореживания» исходного телевизионного сигнала по вертикали и горизонтали, при которой исключается каждая вторая строка и каждый второй отсчет в оставшихся строках. При декомпрессии отброшенные значения восстанавливаются путем интерполяции.

Алгоритм сжатия изображения. Алгоритм компрессии изображений MPEG-1 разрабатывался принципиально ориентированным на обработку последовательностей кадров и использование высокой избыточности информации (до 95% и более), содержащейся в реальных изображениях, разделенных малыми временными интервалами. Действительно, фон в смежных кадрах обычно меняется мало, а все действие связано со смещениями относительно небольших фрагментов изображения. По этой причине необходимость передачи полна информации о кадре изображения возникает только при смене сюжета, а в остальное время можно ограничиваться выделением и передачей разностной информации, характеризующей направления и величины смещения элементе изображения, появление новых объектов или исчезновение старых. Причем такие различия могут выделяться как относительно предыдущих, так и относительно последующих кадров.

Именно такая логика и была реализована в алгоритме MPEG-1, что привело к применению в нем кадров трех типов:

■ I (Intra) - «самостоятельных», играющих роль опорных и сохраняющих полный объем информации о структуре изображения;

■ Р (Predicted) - «предсказываемых» и несущих информацию об изменениях в структуре изображения по сравнению с предыдущим кадром (типа I или P);

■ B (Bi-directional Interpolated) — «двухсторонней интерполяции», сохраняющих только самую существенную часть информации об отличиях от предыдущего и последующего изображений.

Процесс кодирования изображения в MPEG-1 начинается с создания исходного (Intra) кадра, формируемого с применением только внутрикадрового сжатия по технологии JPEG.

Предсказываемые Р – кадры могли бы формироваться просто за счет вычисления их прямой разности относительно предыдущего кадра. Однако такая технология малоэффективна в случаях, например, плавного смещения всего изображения – разностная информация оказывается практически равной объему кадра. В этих условиях значительно лучшие результаты дает использованный в MPEG -l метод оценки перемещений. Для его реализации кадр изображения делится на блоки размером 16x16 пикселей и каждому блоку предыдущего кадра в новом кадре ищется наиболее соответствующий блок, и вычисляются величины векторов смещения для всех блоков. Далее предсказания каждого блока, полученные из предшествующего кадра с помощью соответствующих им векторов смещения, сравниваются с фактическими блоками. Выявленные разности изображений (ошибка предсказания) вместе со значениями векторов смещения, служат информацией для построения предсказываемого кадра, что оказывается значительно экономней передачи содержимого самих блоков.

Алгоритмы кодирования В-кадров зависят от характера картинки. В MPEG-1 предусмотрено четыре способа их кодирования.

■ Первый, самый простой, - компенсация движения и предсказание вперед по предшествующему I или Р - кадру.

■ При появлении в кодируемом В-кадре новых объектов применяется предсказание назад по ближайшему последующему I или Р- кадру вместе с компенсацией движения.

■ Третий алгоритм предусматривает компенсацию движения и двунаправленное предсказание по предшествующему и последующему I или Р- кадрам.

■ Четвертый алгоритм основан на внутрикадровом предсказании без компенсации движения (он обычно используется при резкой смене плана или высоких скоростях движения отдельных фрагментов картинки).

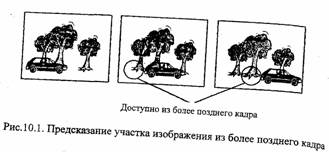

■ Польза В-кадров проясняется при рассмотрении задней границы движущегося объекта. При его движении фон открывается все больше, и для передачи го участка фонового изображения выгоднее воспользоваться данными более позднего кадра (рис.10.1). Кодер рассчитывает как прямое, так и обратное предсказание и посылает декодеру данные, имеющие наименьший объем.

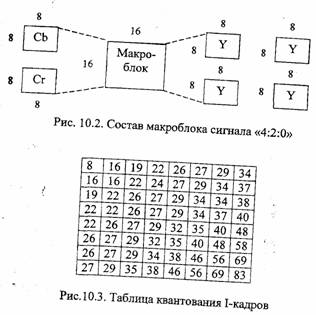

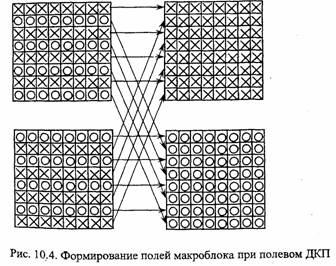

Алгоритм сжатия работает следующим образом. Видеокадр разбивается на макроблоки размером 16 х 16 отсчетов, каждый из которых содержит по 4 блока отсчетов яркости размером 8x8 пикселей и по одному блоку отсчетов сигналов Сb и Сr (с учетом понижающей дискретизации) (рис. 10.2).

При кодировании макроблока в составе 1-кадра вычисляются коэффициенты ДКП, затем они квантуются с использованием таблицы квантования, имеющей в памяти и кодера, и декодера и применяемой «по умолчанию» (Рис.10.3). Кодер может изменить элемента таблицы, тогда он сообщает об этом декодеру и посылает новые данные

Если кодируется макроблок из состава предсказанного кадра, ищется сопряженный блок опорного кадра, его значения поэлементно вычитаются из элементов кодируемого блока, и уже для этих разностей вычисляются коэффициенты ДКП из затем производится их квантование. Таблица квантования для макроблоков из Р- и В – кадров, применяемая по умолчанию, содержит число 16 во всех позициях, но также может быть изменена кодером. Отметим, что при поиске сопряженных блоков используются только отсчеты яркости. Полученные при этом векторы перемещения применяются и при кодировании блоков отсчетов цветоразностных сигналов.

Важным звеном алгоритма кодирования остается обеспечение постоянства выходной скорости цифрового потока. Отсчеты сигнала от источника поступают с постоянной скоростью, однако на выходе квантователя скорость поступают с поступления битов может варьироваться в широких пределах. Она зависит от типа видеокадра (понятно, что I-кадр требует значительно больше битов, чем Р- и В-кадры), от его содержания («спокойный» кадр с однородными участками требует меньше битов, чем кадр с выраженной мелкозернистой структурой). Попытка кодировать все кадры одинаковым числом битов приведет к изменению качества изображения от кадра к кадру, а это крайне неприятно для телезрителя.

Известно, что единственным средством выравнивания скорости потока является применение буферной памяти в кодере и декодере. Буфер может заполняться со стороны квантователя неравными порциями, а опустошаться в сторону канала равномерно, обеспечивая постоянную скорость цифрового потока. Но и здесь не все так просто. Быстрая смена сюжетов и связанное с этим увеличение доли 1-кадров вскоре приведет к переполнению буфера, а длинный сюжет без движения - к его опустошению. Простое увеличение размера буфера вызовет возрастание задержки сигнала в кодере, что в некоторых случаях мешает телезрителям (беседа двух телеведущих в разных студиях).

Для сохранения приемлемого качества изображения при постоянной скорости потока необходимо, во-первых, регулировать шкалу квантования и, во-вторых, адаптивно распределять имеющийся ресурс битов между разными типами кадров с учетом их сложности. Эти задачи решаются в кодере специальным устройством - контроллером битов. Адаптивное управление процессом квантования осуществляется умножением всех элементов матрицы на масштабирующий множитель величиной от 8 до 1/4, общий для всех отсчетов макроблока, который также сообщается декодеру. Величина множителя больше 1 означает увеличение доли битов, выделяемой данному макроблоку или кадру, меньше 1 - соответствующее уменьшение.

Перераспределение ресурса между I-, Р- и В-кадрами производится кодером на основе оценки соотношения битов в предыдущих кадрах. Некоторые кодеры осуществляют кодирование «в два прохода», оценивая на первом проходе сложность видеокадра, выделяя ему на основе этой оценки определенный ресурс битов и уже на втором проходе кодируя отсчеты с учетом выделенного ресурса.

Полученные последовательности I, Р и В-кадров далее объединяются в фиксированные по длине и структуре группы кадров - GOP (Group of Pictures). Каждая такая группа обязательно начинается с I-кадра и с определенной периодичностью содержит Р - кадры. Ее структуру описывают как M/N, где М – общее число кадров в группе, а N – интервал между Р -кадрами.

Итоговый поток данных в значительной степени определяется составом GOP и в зависимости от назначения и требуемого качества изображения (видеофильм, мультимедиа и т. п.) используется различный состав GOP. Так, типичная для VideoCD IPB группа 15/3 имеет вид: IBBPBBPBBPBBPBB. Здесь каждый В-кадр восстанавливается по окружающим его Р -кадрам (в начале и а конце группы - по I и Р), а каждый Р –кадр – по предыдущему Р или 1-кадру. Как уже было сказано, I-кадры являются полностью самостоятельными, служат опорными для Р и В-кадров группы и восстанавливаются независимо от других Достигаемое в такой GOP сжатие, по сравнению с последовательностью только из I-кадров (при одинаковом качестве изображения), составляет около четырех раз.

Несмотря на свою эффективность, стандарт MPEG-1 не лишен недостатков. Например, также как и в JPEG, на однотонном фоне фактически всегда заметна блочная структура. Аналогичная структура проявляется и в быстро меняющихся сценах.

Алгоритм MPEG-1 допускает использование кадров не только формата CIF, но и с другими разрешениями, вплоть до 4095x4095 пикселей. Однако субъективная оценка качества получаемого изображения показывает, что стандарт MPEG-1 можно эффективно использовать только приблизительно на интервале удвоения разрешения и формирования потока видеоданных со скоростями до 3,5 Мбит/с. Дальнейшее повышение качества изображения достигается уже только при кодировании по стандарту MPEG-2.

Сжатие звука. Для компрессии звука в стандарте MPEG-1 также была выбрана технология с потерей данных и, соответственно, с некоторым ухудшением качества по сравнению с исходным.

Основу созданного алгоритма составила так называемая «психоакустическая модель», представляющая собой изученные свойства восприятия звуковых сигналов слуховым аппаратом человека. При этом для сжатия используется методика «кодирования воспринимаемого» (perceptual coding) при которой из исходного звукового сигнала удаляется информация, малозаметная для слуха. В результате, несмотря на изменение формы и спектра сигнала, его слуховое восприятие практически не меняется, а степень сжатия оправдывает незначительное уменьшение качества.

Основные приемы удаления части информации базируются на особенности человеческого слуха, называемой маскированием. Суть эффекта маскирования заключается в том, что при наличии в спектре звука ярко выраженных пиков (преобладающих гармоник) более слабые частотные составляющие, лежащие в непосредственной близости от них, слухом практически не воспринимаются. Ослабляется также чувствительность человеческого слуха и на периоды в 100 мс после и 5 мс до* возникновения сильных (особенно шумовых) звуков. Кроме этого, ухо не способно различать и сигналы, по мощности лежащие ниже определенного уровня, (разного для разных частотных диапазонов). Учет этих особенностей при кодировании позволяет существенно экономить на наименее значимых, с точки зрения восприятия человеком, деталях звучания.

Технически, процесс компрессии включает несколько этапов. Первоначало входной цифровой поток звукового сигнала очищается от заведомо неслышных составляющих (слабые звуки, низкочастотные шумы, наивысшие гармоники) и разбивается на мелкие кадры, каждый из которых затем преобразуется в спектральное представление и делится на ряд частотных полос. Внутри каждой из таких полос производится описанное выделение и удаление маскируемых звуков, обеспечивающее общее сокращение объема данных сразу более чем в два раза. Далее каждый кадр подвергается адаптивному кодированию прямо в спектральной форме.

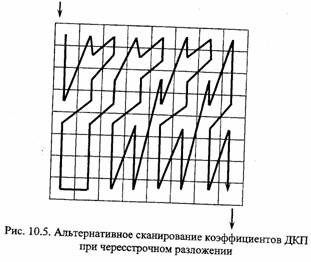

При декодировании серия сжатых мгновенных спектров сигнала преобразуется обратно в обычную цифровую волновую форму.