УЗБЕКСКОЕ АГЕНСТВО СВЯЗИ И

ИНФОРМАТИЗАЦИИ

ТАШКЕНТСКИЙ УНИВЕРСИТЕТ

ИНФОРМАЦИОННЫХ ТЕХНОЛОГИЙ

ФАКУЛЬТЕТ

"ИНФОРМАЦИОННЫХ ТЕХНОЛОГИЙ"

КОНСПЕКТ ЛЕКЦИЙ ПО КУРСУ

«ОПЕРАЦИОННЫЕ СИСТЕМЫ»

|

№ |

Содержание |

|

|

|

Введение. |

3 |

|

Глава 1. |

Основные понятия |

5 |

|

Глава 2. |

Управление задачами |

47 |

|

Глава 3. |

Управление памятью в операционных системах |

72 |

|

Глава 4. |

Особенности архитектуры микропроцессоров i80x86

для организации мультипрограммных операционных систем |

104 |

|

Глава 5. |

Управление вводом-выводом в операционных системах |

136 |

|

Глава 6. |

Файловые системы |

172 |

|

Глава 7. |

Организация параллельных взаимодействующих

вычислений |

222 |

|

Глава 8. |

Проблема тупиков и методы борьбы с ними |

262 |

|

Глава 9. |

Архитектура операционных систем |

291 |

|

Глава 10. |

Краткий обзор современных операционных систем |

328 |

Введение

Как известно, процесс проникновения

информационных технологий практически во все сферы человеческой деятельности

продолжает развиваться и углубляться. Помимо уже привычных и широко

распространенных персональных компьютеров, общее число которых достигло многих

сотен миллионов, становится все больше и встроенных средств вычислительной

техники. Пользователей всей этой разнообразной вычислительной техники

становится все больше, причем наблюдается развитие двух вроде бы

противоположных тенденций. С одной стороны, информационные технологии все

усложняются, и для их применения, и тем более дальнейшего развития, требуется

иметь очень глубокие познания. С другой стороны, упрощаются интерфейсы

взаимодействия пользователей с компьютерами. Компьютеры и информационные

системы становятся все более дружественными и понятными даже для человека, не

являющегося специалистом в области информатики и вычислительной техники. Это

стало возможным прежде всего потому, что пользователи и их программы

взаимодействуют с вычислительной техникой посредством специального (системного)

программного обеспечения — через операционную систему.

Операционная система предоставляет интерфейсы и для

выполняющихся приложений, и для пользователей. Программы пользователей, да и

многие служебные программы запрашивают у операционной системы выполнение тех

операций, которые достаточно часто встречаются практически в любой программе.

К таким операциям, прежде всего, относятся операции ввода-вывода, запуск или

останов какой-нибудь программы, получение дополнительного блока памяти или его

освобождение и многие другие. Подобные операции невыгодно каждый раз программировать

заново и непосредственно размещать в виде двоичного кода в теле программы, их

удобнее собрать вместе и предоставлять для выполнения по запросу из программ.

Это и есть одна из важнейших функций операционных систем. Прикладные

программы, да и многие системные обрабатывающие программы (такие, например, как

системы программирования или системы управления базами данных), не имеют

непосредственного доступа к аппаратуре компьютера, а взаимодействуют с ней

только через обращения к операционной системе. Пользователи также путем ввода

команд операционной системы или выбором возможных действий, предлагаемых

системой, взаимодействуют с компьютером и своими программами. Такое

взаимодействие осуществляется исключительно через операционную систему. Помимо

выполнения этой важнейшей функции операционные системы отвечают за эффективное

распределение вычислительных ресурсов и организацию надежных вычислений.

Знание основ организации операционных систем и принципов их

функционирования позволяет использовать компьютеры более эффективно. Глубокое

изучение операционных систем позволяет применить эти знания прежде всего при

создании программного обеспечения. Если, к большому сожалению, в нашей стране

в последние годы практически не создаются новые операционные системы, то разработки

сложных информационных систем, комплексов программ и отдельных приложений,

предназначенных для работы в широко распространенных операционных системах,

ведутся достаточно интенсивно, причем большим числом организаций. И здесь

знание операционных систем, принципов их функционирования, методов организации

вычислений является не только желательным, но обязательным.

Глава 1. Основные понятия

Эта глава является вводной и, пожалуй, самой главной. Любой

предмет имеет свои основные понятия и положения. Не является исключением и

дисциплина «Операционные системы». К основным понятиям, без которых

практически невозможно по-настоящему изучить эту дисциплину, понять основные

принципы организации вычислений, взаимодействия прикладных программ с

операционной системой и пользователей с компьютерами, следует, прежде всего,

отнести понятия вычислительных процессов и ресурсов, системной программы,

супервизора, операционной среды, прерываний. Мы также рассмотрим относительно

новые понятия, к которым относятся поток выполнения и задача: они дополняют понятие

вычислительного процесса и позволяют более эффективно организовать работу

компьютера. Поскольку абсолютное большинство операционных систем обеспечивают

возможность параллельного выполнения нескольких программ, мы познакомимся с

понятием мультипрограммирования. Завершается глава обзором основных общепринятых

классификаций.

Назначение

и функции операционных систем

Операционные системы относятся к системному программному

обеспечению. Как известно, все программное обеспечение разделяется на системное

и прикладное. К системному программному обеспечению принято относить такие

программы и комплексы программ, которые являются общими, без которых невозможно

выполнение или создание других программ. История появления и развития системного

программного обеспечения началась с того момента, когда люди осознали, что

любая программа требует операций ввода-вывода данных. Это произошло в далекие

50-е годы прошлого столетия. Собственно операционные системы появились чуть

позже.

Действительно,

если мы не будем иметь возможности изменять исходные данные и получать

результаты вычислений, то зачем вообще эти вычисления? Очевидно, что исходные

данные могут вводиться различными способами. На практике используются самые

разнообразные устройства и методы. Например, мы можем вводить исходные значения

с клавиатуры, задавать нужные действия или функции с помощью указателя мыши,

считывать записи из файла, снимать оцифрованные значения с датчиков и т. д.

Часть исходных данных может быть передана в программу через область памяти, и

которую предварительно другая программа занесла свои результаты вычислений.

Способов много. Главное — выполнить в программе некоторые действия, связанные

с получением исходных данных.

Аналогично, и вывод результатов может быть организован,

например, на соответствующие устройства и в форме, удобной для восприятия ее

человеком. Либо результаты расчетов будут отправляться программой на

какие-нибудь исполнительные устройства, которые управляются компьютером.

Наконец, мы можем организовать запись полученных значений на некие устройства

хранения данных (с целью их дальнейшей обработки).

Программирование операций ввода-вывода относится к одной из

самых трудоемких областей создания программного обеспечения. Здесь речь идет

не об использовании операторов типа READ или WRITE в языках высокого уровня. Речь идет о необходимости создать

подпрограмму в машинном виде, уже готовую к выполнению на компьютере, а не

написанную с помощью некоторой системы программирования (систем

программирования тогда еще не было), подпрограмму, вместо обычных вычислений

управляющую тем устройством, которое должно участвовать в операциях ввода

исходных данных или вывода результатов. При наличии такой подпрограммы

программист может обращаться к ней столько раз, сколько операций ввода-вывода с

этим устройством ему требуется. Для выполнения этой работы программисту

недостаточно хорошо знать архитектуру вычислительного комплекса и уметь

создавать программы на языке ассемблера. Он должен отлично знать и интерфейс, с

помощью которого устройство подключено к центральной части компьютера, и

алгоритм функционирования устройства управления устройства ввода-вывода.

Очевидно, что имело смысл создать набор подпрограмм

управления операциями ввода-вывода и использовать его в своих программах, чтобы

не заставлять программистов каждый раз заново программировать все эти

операции, С этого и началась история системного программного обеспечения.

Впоследствии набор подпрограмм ввода-вывода стали организовывать в виде

специальной библиотеки ввода-вывода, а затем появились и сами операционные

системы. Основной причиной их появления было желание автоматизировать процесс

подготовки вычислительного комплекса к выполнению программы.

В 50-е годы взаимодействие пользователей с вычислительным

комплексом было совершенно иным, чем нынче. Программист-кодер (от англ. coder – кодировщик) – специально подготовленный специалист,

знающий архитектуру компьютера язык(и) программирования, - по заказу составлял

текст программы, часто по уже готовому алгоритму, разработанному

программистом-алгоритмистом. Текст этой программы затем отдавался оператору,

который набирал его-на специальных устройствах и переносил на соответствующие

носители. Чаще всего в качестве носителей использовались перфокарты или

перфолента. Далее колода с перфокартами (перфолента) передавалась в

вычислительный зал, где для вычислений по этой программе следующие действия.

1. Оператор

вычислительного комплекса с пульта вводил в рабочие регистры центрального

процессора и в оперативную память компьютера ту первоначальную программу,

которая позволяла считать в память программу для трансляции исходных кодов и

получения машинной (двоичной) программы (проще говоря, транслятор, который

тоже хранился на перфокартах или перфоленте).

2. Транслятор

считывал исходную программу, осуществлял лексический разбор исходного текста, и

промежуточные результаты процесса трансляции зачастую так же выводили на

перфокарты (перфоленту). Трансляция — сложный процесс, часто требующий

нескольких проходов. Порой для выполнения очередного прохода приходилось в

память компьютера загружать с перфокарт и следующую часть транслятора, и

промежуточные результаты трансляции. Ведь результат трансляции выводился также

на носители информации, поскольку объем оперативной памяти был небольшим, а

задача трансляции — это очень сложная задача.

3. Оператор загружал

в оперативную память компьютера полученные двоичные коды оттранслированной

программы и подгружал двоичные коды тех системных подпрограмм, которые

реализовывали управление операциями ввода-вывода. После этого готовая

программа, расположенная в памяти, могла сама считывать исходные данные и осуществлять

необходимые вычисления.

В случае обнаружения ошибок на одном из этих этапов или

после анализа полученных результатов весь цикл необходимо было повторить.

Для автоматизации труда программиста (кодера) стали

разрабатывать специальные алгоритмические языки высокого уровня, а для

автоматизации труда оператора вычислительного комплекса была разработана

специальная управляющая программа, загрузив которую в память один раз оператор

мог ее далее использовать неоднократно и более не обращаться к процедуре

программирования ЭВМ через пульт оператора. Именно эту управляющую программу и

стали называть операционной системой. Со временем на нее стали возлагать все

больше и больше задач, она стала расти в объеме. Прежде всего разработчики

стремились к тому, чтобы операционная система как можно более эффективно

распределяла вычислительные ресурсы компьютера, ведь в 60-е годы операционные

системы уже позволяли организовать параллельное выполнение нескольких

программ. Помимо задач распределения ресурсов появились задачи обеспечения

надежности вычислений. К началу 70-х годов диалоговый режим работы с

компьютером стал преобладающим, и у операционных систем стремительно начали

развиваться интерфейсные возможности. Напомним, что термином интерфейс (interface) обозначают целый комплекс спецификаций,

определяющих конкретный способ взаимодействия пользователя с компьютером.

На сегодняшний день можно констатировать, что операционная

система (ОС) представляет собой комплекс системных1 управляющих

и обрабатывающих программ, которые, с одной стороны, выступают как интерфейс

между аппаратурой компьютера и пользователем с его задачами, а с другой

стороны,

1

Системными принято называть такие программы, которые используются всеми

остальными программами.

предназначены для наиболее эффективного расходования

ресурсов вычислительной системы и организации надежных вычислений.

Можно попробовать перечислить основные функции

операционных систем.

·

Прием

от пользователя (или от оператора системы) заданий, или команд, сформулированных

на соответствующем языке, и их обработка. Задания могут передаваться в виде

текстовых директив (команд) оператора или в форме указаний, выполняемых с

помощью манипулятора (например, с помощью мыши). Эти команды связаны, прежде

всего, с запуском (приостановкой, остановкой) программ, с операциями над

файлами (получить перечень файлов в текущем каталоге, создать, переименовать,

скопировать, переместить тот или иной файл и др.). хотя имеются и иные команды.

·

Загрузка

в оперативную память подлежащих исполнению программ.

·

Распределение

памяти, а в большинстве современных систем и организация виртуальной памяти.

·

Запуск

программы (передача ей управления, в результате чего процессор исполняет

программу).

·

Идентификация

всех программ и данных.

·

Прием

и исполнение различных запросов от выполняющихся приложений. Операционная

система умеет выполнять очень большое количество системных функций (сервисов),

которые могут быть запрошены из выполняющейся программы. Обращение к этим

сервисам осуществляется по соответствующим правилам, которые и определяют интерфейс

прикладного программирования (Application Program Interface) этой операционной системы.

·

Обслуживание

всех операций ввода-вывода.

·

Обеспечение

работы систем управлений файлами (СУФ) и/или систем управления базами данных

(СУБД), что позволяет резко увеличить эффективность всего программного

обеспечения.

·

Обеспечение

режима мультипрограммирования, то есть организация параллельного выполнения

двух или более программ на одном процессоре, создающая видимость их

одновременного исполнения.

·

Планирование

и диспетчеризация задач в соответствии с заданными стратегией и дисциплинами

обслуживания.

·

Организация

механизмов обмена сообщениями и данными между выполняющимися программами.

·

Для

сетевых операционных систем характерной является функция обеспечения

взаимодействия связанных между собой компьютеров.

·

Защита

одной программы от влияния другой, обеспечение сохранности данных, защита

самой операционной системы от исполняющихся на компьютере приложений.

·

Аутентификация

и авторизация пользователей (для большинства диалоговых операционных систем).

Под аутентификацией понимается процедура проверки имени пользователя и

его пароля на соответствие тем значениям, которые хранятся в его учетной

записи1. Очевидно, что если входное имя (login2) пользователя и его пароль совпадают, то, скорее всего, это и

будет тот самый пользователь. Термин авторизация означает, что в

соответствии с учетной записью пользователя, который прошел аутентификацию,

ему (и всем запросам, которые будут идти к операционной системе от его имени)

назначаются определенные права (привилегии), определяющие, что он может, а что

не может делать на компьютере.

·

Удовлетворение

жестким ограничениям на время ответа в режиме реального времени (характерно для

операционных систем реального времени).

·

Обеспечение

работы систем программирования, с помощью которых пользователи готовят свои

программы.

·

Предоставление

услуг на случай частичного сбоя системы.

Операционная система изолирует аппаратное обеспечение

компьютера от прикладных программ пользователей. И пользователь, и его

программы взаимодействуют с компьютером через интерфейсы операционной системы.

Это можно проиллюстрировать, например, рис. 1.1.

Рис.

1.1. Взаимодействие

пользователя и его программ с

компьютером

через

операционную систему

Понятие

операционной среды

Итак, операционная система выполняет функции управления

вычислениями в компьютере, распределяет ресурсы вычислительной системы между

различными вычислительными процессами и образует ту программную среду, в

которой выполняются прикладные программы пользователей. Такая среда называется операционной.

Последнее следует понимать в том плане, что при запуске программы она будет

обращаться к операционной системе с соответствующими запросами на выполнение

определенных действий, или функций. Эти функции операционная система выполняет,

запуская специальные системные программные модули, входящие в ее состав.

Итак, при создании двоичных машинных программ прикладные

программисты могут вообще не знать многих деталей управления конкретными

ресурсами вычислительной системы, а должны только обращаться к некоторой

программной подсистеме с соответствующими вызовами и получать от нее

необходимые функции и сервисы. Эта программная подсистема и есть операционная

система, а набор ее функций и сервисов, а также правила обращения к ним как раз

и образуют то базовое понятие, которое мы называем операционной средой. Таким

образом, можно сказать, что термин «операционная среда» означает, прежде

всего, соответствующие интерфейсы, необходимые программам и пользователям для

обращения к управляющей (супервизорный) части операционной системы с

целью получить определенные сервисы.

Системных функций бывает много, они определяют те

возможности, которые операционная система предоставляет выполняющимся под ее

управлением приложениям. Такого рода системные запросы (вызовы

системных операций, или функций) либо явно прописываются в тексте программы

программистами, либо подставляются автоматически самой системой

программирования на этапе трансляции исходного текста разрабатываемой

программы. Каждая операционная система имеет свое множество системных функций;

они вызываются соответствующим образом, по принятым в системе правилам.

Совокупность системных вызовов и правил, по которым их следует использовать,

как раз и определяет уже упомянутый нами интерфейс прикладного программирования

(API). Очевидно, что

программа, созданная для работы в некоторой операционной системе, скорее всего

не будет работать в другой операционной системе, поскольку API у этих операционных систем, как правило,

различаются. Стараясь преодолеть это ограничение, разработчики операционных

систем стали создавать так называемые программные среды. Программную

(системную) среду следует понимать как некоторое системное программное

окружение, позволяющее выполнить все системные запросы от прикладной

программы. Та системная программная среда, которая непосредственно образуется

кодом операционной системы, называется основной, естественной, или

нативной (native).

Помимо основной операционной среды в операционной системе могут быть

организованы (путем эмуляции иной операционной среды) дополнительные

программные среды. Если в операционной системе организована работа с различными

операционными средами, то в такой системе можно выполнять программы, созданные

не только для данной, но и для других операционных систем.

Можно сказать, что программы создаются для работы в некоторой

заданной операционной среде. Например, можно создать программу для работы в

среде DOS, Если такая

программа все функции, связанные с операциями ввода-вывода и с запросами

памяти, выполняет не сама, а за счет обращения к системным функциям DOS, то она будет (в абсолютном большинстве

случаев) успешно выполняться и в MS DOS, и в PC DOS, и в Windows 9х, и в Windows 2000, и в OS/2, и даже в Linux. Итак, параллельное существование терминов «операционная система»

и «операционная среда» вызвано тем, что операционная система (в общем случае)

может поддерживать несколько операционных сред. Почти все современные 32-разрядные

операционные системы, созданные для персональных компьютеров, поддерживают по

нескольку операционных сред. Так, операционная система OS/2 Warp, которая в свое время была одной из

лучших в этом отношении, может выполнять следующие программы:

·

основные

программы, созданные с учетом соответствующего «родного» 32-разряднго

программного интерфейса этой операционной системы;

·

16-разрядные

программы, созданные для систем OS/2 первого поколения;

·

16-разрядные

приложения, разработанные для выполнения в операционной среде MS DOS или PC DOS;

·

16-разрядные

приложения, созданные для операционной среды Windows 3.x;

·

саму

операционную оболочку Windows 3.x и уже в ней —

созданные для нее программы.

А операционная система Windows XP позволяет выполнять помимо основных

приложений, созданных с использованием Win32API, 16-разрядные приложения для Windows 3.x, 16-разрядные DOS-приложения, 16-разрядные приложения для первой версии OS/2.

Операционная среда может включать несколько интерфейсов:

пользовательские и программные. Если говорить о пользовательских, то, например,

система Linux имеет для

пользователя как интерфейсы командной строки (можно использовать различные

«оболочки» — shell),

наподобие Norton Commander, например Midnight Commander, так и графические интерфейсы, например X-Window с различными менеджерами окон — KDE, Gnome и др. Если же говорить о программных интерфейсах, то в тех

же операционных системах с общим названием Linux программы могут обращаться как к операционной системе за

соответствующими сервисами и функциями, так и к графической подсистеме (если

она используется). С точки зрения архитектуры процессора (и персонального

компьютера в целом) двоичная программа, созданная для работы в среде Linux, использует те же команды и форматы

данных, что и программа, созданная для работы в среде Windows NT. Однако в первом случае мы имеем

обращение к одной операционной среде, а во втором — к другой. И программа,

созданная непосредственно для Windows. не будет выполняться в Linux; однако если в операционной системе Linux организовать полноценную операционную среду Windows, то наша Windows - программа может быть выполнена. Завершая этот раздел,

можно еще раз сказать, что операционная среда — это то системное программное

окружение, в котором могут выполняться программы, созданные по правилам работы

этой среды.

Прерывания

Прерывания представляют собой механизм, позволяющий

координировать параллельное функционирование отдельных устройств вычислительной

системы и реагировать на особые состояния, возникающие при работе процессора,

то есть прерывание — это принудительная передача управления от выполняемой

программы системе (а через нее — к соответствующей программе обработки

прерывания), происходящая при возникновении определенного события.

Идея прерывания была предложена также очень давно — в

середине 50-х годов, — можно без преувеличения сказать, что она внесла наиболее

весомый вклад в развитие вычислительной техники. Основная цель введения

прерываний — реализация асинхронного режима функционирования и

распараллеливание работы отдельных устройств вычислительного комплекса.

Механизм прерываний реализуется аппаратно-программными

средствами. Структуры систем прерывания (в зависимости от аппаратной

архитектуры) могут быть самыми разными, но все они имеют одну общую особенность

— прерывание непременно влечет за собой изменение порядка выполнения команд

процессором.

Механизм обработки прерываний независимо от архитектуры

вычислительной системы подразумевает выполнение некоторой последовательности

шагов.

1. Установление

факта прерывания (прием сигнала запроса на прерывание) и идентификация

прерывания (в операционных системах идентификация прерывания иногда осуществляется

повторно, на шаге 4).

2. Запоминание

состояния прерванного процесса вычислений. Состояние процесса выполнения

программы определяется, прежде всего, значением счетчика команд (адресом

следующей команды, который, например, в i80x86 определяется регистрами CS и IP — указателем команды [1, 8, 48]),

содержимым регистров процессора, и может включать также спецификацию режима

(например, режим пользовательский или привилегированный) и другую информацию.

3. Управление

аппаратно передается на подпрограмму обработки прерывания. В простейшем случае

в счетчик команд заносится начальный адрес подпрограммы обработки прерываний,

а в соответствующие регистры — информация из слова состояния. В более развитых

процессорах, например в 32-разрядных микропроцессорах фирмы Intel (начиная с i80386 и включая последние процессоры Pentium IV) и им подобных, осуществляются достаточно

сложная процедура определения начального адреса соответствующей подпрограммы

обработки прерывания и не менее сложная процедура инициализации рабочих

регистров процессора (подробно эти вопросы рассматриваются в разделе «Система

прерываний 32-разрядных микропроцессоров i80x86» главы 4).

4. Сохранение

информации о прерванной программе, которую не удалось спасти на шаге 2 с

помощью аппаратуры. В некоторых процессорах предусматривается запоминание

довольно большого объема информации о состоянии прерванных вычислений.

5. Собственно

выполнение программы, связанной с обработкой прерывания. Эта работа может быть

выполнена той же подпрограммой, на которую было передано управление на шаге 3,

но в операционных системах достаточно часто она реализуется путем последующего

вызова соответствующей подпрограммы.

6. Восстановление

информации, относящейся к прерванному процессу (этап, обратный шагу 4).

7. Возврат на прерванную программу.

Шаги 1-3

реализуются аппаратно, шаги 4-7 — программно.

На рис. 1.2 показано, что при возникновении запроса на

прерывание естественный ход вычислений нарушается и управление передается на

программу обработки возникшего прерывания. При этом средствами аппаратуры

сохраняется (как правило, с помощью механизмов стековой памяти) адрес той

команды, с которой следует продолжить выполнение прерванной программы. После

выполнения программы обработки прерывания управление возвращается на прерванную

ранее программу посредством занесения в указатель команд сохраненного адреса

команды, которую нужно было бы выполнить, если бы не возникло прерывание.

Однако такая схема используется только в самых простых программных средах. В

мультипрограммных операционных системах обработка прерываний происходит по

более сложным схемам, о чем будет более подробно написано ниже. Итак, главные

функции механизма прерываний — это:

·

распознавание

или классификация прерываний;

·

передача

управления соответствующему обработчику прерываний;

·

корректное

возвращение к прерванной программе.

Переход от прерываемой программы к обработчику и обратно

должен выполняться как можно быстрей. Одним из самых простых и быстрых методов

является использование таблицы, содержащей перечень всех допустимых для

компьютера прерываний и адреса соответствующих обработчиков. Для корректного

возвращения к прерванной программе перед передачей управления обработчику

прерываний содержимое регистров процессора запоминается либо в памяти с прямым

доступом, либо в системном стеке (system stack).

Прерывания, возникающие при работе вычислительной системы,

можно разделить на два основных класса: внешние (их иногда называют

асинхронными) и внутренние (синхронные).

Внешние прерывания вызываются асинхронными событиями, которые

происходят вне прерываемого процесса, например:

·

прерывания

от таймера;

·

прерывания

от внешних устройств (прерывания по вводу-выводу);

·

прерывания

по нарушению питания;

·

прерывания

с пульта оператора вычислительной системы;

·

прерывания

от другого процессора или другой вычислительной системы. Внутренние

прерывания вызываются событиями, которые связаны с работой процессора и

являются синхронными с его операциями. Примерами являются следующие запросы на

прерывания:

·

при

нарушении адресации (в адресной части выполняемой команды указан запрещенный

или несуществующий адрес, обращение к отсутствующему сегменту или странице при

организации механизмов виртуальной памяти);

·

при наличии

в поле кода операции незадействованной двоичной комбинации;

·

при

делении на ноль;

·

вследствие

переполнения или исчезновения порядка;

·

от

средств контроля (например, вследствие обнаружения ошибки четности, ошибок в

работе различных устройств).

![]()

Рис. 1.2. Обработка прерывания

Могут еще существовать прерывания в связи с попыткой

выполнить команду, которая сейчас запрещена. Во многих компьютерах часть команд

должна выполняться только кодом самой операционной системы, но не прикладными

программами. Это делается с целью повышения защищенности выполняемых на

компьютере вычислении. Соответственно в аппаратуре предусмотрены различные

режимы работы, пользовательские программы выполняются в режиме, в котором некоторое подмножество команд, называемых

привилегированными, не исполняется. К привилегированным командам помимо команд

ввода-вывода относятся и команды переключения режима работа центрального

процессора, и команды инициализации некоторых системных регистров процессора.

При попытке использовать команду, запрещенную в данном режиме, происходит

внутреннее прерывание, и управление передается самой операционной системе.

Наконец, существуют собственно программные прерывания. Эти

прерывания происходят по соответствующей команде прерывания, то есть по этой

команде процессор осуществляет практически те же действия, что и при обычных

внутренних прерываниях. Этот механизм был специально введен для того, чтобы

переключение на системные программные модули происходило не просто как переход

на подпрограмму, а точно таким же образом, как и обычное прерывание. Этим, прежде

всего, обеспечивается автоматическое переключение процессора в привилегированный

режим с возможностью исполнения любых команд. Сигналы, вызывающие прерывания,

формируются вне процессора или в самом процессоре, они могут возникать одновременно.

Выбор одного из них для обработки осуществляется на основе приоритетов,

приписанных каждому типу прерывания. Так, со всей очевидностью, прерывания от

схем контроля процессора должны обладать наивысшим приоритетом (действительно,

если аппаратура работает неправильно, то не имеет смысла продолжать обработку

информации). На рис. 1.3 изображен обычный порядок (приоритеты) обработки

прерываний в зависимости от типа прерываний. Учет приоритета может быть встроен

в технические средства, а также определяться операционной системой, то есть

кроме аппаратно реализованных приоритетов прерывания большинство

вычислительных машин и комплексов допускают программно-аппаратное управление

порядком обработки сигналов прерывания. Второй способ, дополняя первый, позволяет

применять различные дисциплины обслуживания прерываний.

Рис. 1.3.

Распределение прерываний по уровням приоритета

Наличие

сигнала прерывания не обязательно должно вызывать прерывание исполняющейся программы.

Процессор может обладать средствами защиты от прерываний: отключение системы

прерываний, маскирование (запрет) отдельных сигналов прерывания. Программное

управление этими средствами (существуют специальные команды для управления

работой системы прерываний) позволяет операционной системе регулировать

обработку сигналов прерывания, заставляя процессор обрабатывать их сразу по

приходу; откладывать обработку на некоторое время; полностью игнорировать

прерывания. Обычно операция прерывания выполняется только после завершения

выполнения текущей команды. Поскольку сигналы прерывания возникают в

произвольные моменты времени, то на момент прерывания может существовать

несколько сигналов прерывания, которые могут быть обработаны только

последовательно. Чтобы обработать сигналы прерывания в разумном порядке, им

(как уже отмечалось) присваиваются приоритеты. Сигнал с более высоким

приоритетом обрабатывается в первую очередь, обработка остальных сигналов

прерывания откладывается.

Программное управление специальными регистрами маски

(маскирование сигналов прерывания) позволяет реализовать различные дисциплины

обслуживания.

·

С

относительными приоритетами, то есть обслуживание не прерывается даже при наличии запросов с

более высокими приоритетами. После окончания обслуживания данного запроса обслуживается

запрос с наивысшим приоритетом. Для организации такой дисциплины необходимо в

программе обслуживания данного запроса наложить маски на все остальные сигналы

прерывания или просто отключить систему прерываний.

·

С

абсолютными приоритетами, то

есть всегда обслуживается прерывание с наивысшим приоритетом. Для реализации

этого режима необходимо на время обработки прерывания замаскировать все запросы

с более низким приоритетом. При этом возможно многоуровневое прерывание, то

есть прерывание программ обработки прерываний. Число уровней прерывания в этом

режиме изменяется и зависит от приоритета запроса.

·

По принципу

стека, или, как иногда говорят, по дисциплине LCFS (Last Come First Served - последним пришел, первым обслужен), то есть запросы с более низким

приоритетом могут прерывать обработку прерывания с более высоким приоритетом.

Дли этого необходимо не накладывать маску ни на один из сигналов прерывания и

не выключать систему прерываний.

Следует особо отметить, что для правильной реализации

последних двух дисциплин нужно обеспечить полное маскирование системы

прерываний при выполнении шагов 1-4 и 6-7. Это необходимо для того, чтобы не

потерять запрос и правильно его обслужить. Многоуровневое прерывание должно

происходить на этапе собственно обработки прерывания, а не на этапе перехода с

одного процесса вычислений на другой.

Управление ходом выполнения задач со стороны операционной

системы заключается в организации реакций на прерывания, в организации обмена

информацией (Данными и программами), в предоставлении необходимых ресурсов, в

динамике выполнения задачи и в организации сервиса. Причины прерываний

определяет операционная система (модуль, который называют супервизором

прерываний), она же и выполняет действия, необходимые при данном прерывании

и в данной ситуации. Поэтому в состав любой операционной системы реального

времени прежде всего входят программы управления системой прерываний, контроля

состояний задач и событий, синхронизации задач, средства распределения памяти и

управления ею, а уже потом средства организации данных (с помощью файловых

систем и т. д. Следует однако заметить, что современная операционная система

реального времени должна вносить в аппаратно-программный комплекс нечто

большее, нежели просто обеспечение быстрой реакции на прерывания.

Как мы уже знаем, при появлении запроса на прерывание

система прерываний идентифицирует сигнал и, если прерывания разрешены, то

управление передается на соответствующую подпрограмму обработки. Из рис. 1.2

видно, что в подпрограмме обработки прерывания имеется две служебные секции.

Это - первая секция, в которой осуществляется сохранение контекста прерываемых

вычислений, который не смог быть сохранен на шаге 2, и последняя,

заключительная секция, в которой, наоборот, осуществляется восстановление

контекста. Для того чтобы система прерываний не среагировала повторно на

сигнал запроса на прерывание, она обычно автоматически «закрывает» (отключает)

прерывания, поэтому необходимо потом в подпрограмме обработки прерываний вновь

включать систему прерываний. В соответствии с рассмотренными режимами

обработки прерываний (с относительными и абсолютными приоритетами и по правилу LCFS) установка этих режимов осуществляется в

конце первой секции подпрограммы обработки. Таким образом, на время выполнения

центральной секции (в случае работы в режимах с абсолютными приоритетами и по

дисциплине LCFS)

прерывания разрешены. На время работы заключительной секции подпрограммы

обработки система прерываний вновь должна быть отключена и после

восстановления контекста опять включена. Поскольку эти действия необходимо

выполнять практически в каждой подпрограмме обработки прерываний, во многих

операционных системах первые секции подпрограмм обработки прерываний

выделяются в уже упоминавшийся специальный системный программный модуль,

называемый супервизором прерываний.

Супервизор прерываний прежде всего сохраняет в дескрипторе

текущей задачи рабочие регистры процессора, определяющие контекст прерываемого

вычислительного процесса. Далее он определяет ту подпрограмму, которая должна

выполнить действия, связанные с обслуживанием настоящего (текущего) запроса на

прерывание. Наконец, перед тем, как передать управление на эту подпрограмму,

супервизор прерываний устанавливает необходимый режим обработки прерывания.

После выполнения подпрограммы обработки прерывания управление вновь передается

ядру операционной системы. На этот раз уже на тот модуль, который занимается

диспетчеризацией задач (см. раздел «Планирование и диспетчеризация процессов и

задач» в главе 2). И уже диспетчер задач, в свою очередь, в соответствии с

принятой дисциплиной распределения процессорного времени (между выполняющимися

вычислительными процессами) восстановит контекст той задачи, которой будет

решено выделить процессор. Рассмотренную нами схему иллюстрирует рис, 1.4.

Как мы видим из рисунка, здесь отсутствует возврат в

прерванную ранее программу непосредственно из самой подпрограммы обработки

прерывания. Для прямого возврата достаточно адрес возврата сохранить в стеке,

что и делает аппаратура процессора. При этом стек легко обеспечивает

возможность возврата в случае вложенных прерываний, поскольку он всегда

реализует дисциплину LCFS.

![]()

Рис. 1.4. Обработка прерывания при участии

супервизоров ОС

Однако если бы контекст вычислительных процессов сохранялся

просто в стеке, как это обычно реализуется аппаратурой, а не в специальных

структурах данных, называемых дескрипторами, о чем будет подробно изложено чуть

позже, то у нас не было бы возможности гибко подходить к выбору той задачи,

которой нужно передать процессор после завершения работы подпрограммы обработки

прерывания. Естественно, что это только общий принцип. В конкретных процессорах

и в конкретных операционных системах могут существовать некоторые отступления от

рассмотренной схемы и/или дополнения. Например, в современных процессорах часто

имеются специальные аппаратные возможности для сохранения контекста

прерываемого вычислительного процесса

непосредственно в его дескрипторе, то есть дескриптор процесса (по крайней мере

его часть) становится структурой которую поддерживает аппаратура.

Для полного понимания принципов создания и механизмов

реализации рассматриваемых далее современных операционных систем необходимо

знать архитектуру и, в частности, особенности системы прерывания персональных

компьютеров. Этот вопрос более подробно рассмотрен в главе 4, посвященной

архитектуре микропроцессоров i80x86.

Понятия

вычислительного процесса и ресурса

Понятие последовательного1 вычислительного

процесса, или просто процесса, является одним из основных при

рассмотрении операционных систем. Как понятие процесс является

определенным видом абстракции, и мы будем придерживаться следующего

неформального определения, приведенного в [47]. Последовательный процесс,

иногда называемый задачей2 (task), — это отдельная программа с ее данными,

выполняющаяся на последовательном процессоре. Напомним, что под

последовательным мы понимаем такой процессор, в котором текущая команда

выполняется после завершения предыдущей. В современных процессорах мы сталкиваемся

с ситуациями, когда возможно параллельное выполнение нескольких команд. Это

делается для повышения скорости вычислений. В этих процессорах параллелизм

достигается двумя основными способами — организацией конвейерного механизма

выполнения команды и созданием нескольких конвейеров. Однако в подобных

процессорах аппаратными решениями обязательно достигается логическая

последовательность в выполнении команд, предусмотренная программой.

Необходимость этого объясняется в главе 7, посвященной организации параллельных

вычислительных процессов.

Концепция процесса предполагает два аспекта: во-первых, он

является носителем данных и, во-вторых, он собственно и выполняет операции,

связанные с обработкой этих данных.

В качестве примеров процессов (задач) можно назвать

прикладные программы пользователей, утилиты и другие системные обрабатывающие

программы. Процессом может быть редактирование какого-либо текста, трансляция

исходной программы, се компоновка, исполнение. Причем трансляция какой-нибудь

исходной программы является одним процессом, а трансляция следующей исходной

программы — другим процессом, поскольку транслятор как объединение программных

модулей здесь выступает как одна и та же программа, но данные, которые он

обрабатывает, являются разными.

Концепция процесса преследует цель выработать механизмы

распределения и управления ресурсами. Понятие ресурса, так же как и понятие

процесса, является, пожалуй, основным

при рассмотрении операционных систем. Термин ресурс обычно применяется по

отношению к многократно используемым, относительно стабильным и часто

недостающим объектам, которые запрашиваются, задействуются и освобождаются в

период их активности. Другими словами, ресурсом называется всякий объект,

который может распределяться внутри системы. Ресурсы могут быть разделяемыми,

когда несколько процессов используют их одновременно (в один и тот

же момент времени) или параллельно (попеременно в течение некоторого

интервала времени), а могут быть и неделимыми (рис. 1.5).

Рис. 1.5. Классификация ресурсов

При разработке первых систем ресурсами считались

процессорное время, память, каналы ввода-вывода и периферийные устройства [22,

53]. Однако очень скоро понятие ресурса стало гораздо более универсальным и

общим. Различного рода программные и информационные ресурсы также могут быть

определены для системы как объекты, которые могут разделяться и распределяться

и доступ к которым необходимо соответствующим образом контролировать. В

настоящее время понятие ресурса превратилось в абстрактную структуру с целым

рядом атрибутов, характеризующих способы доступа к этой структуре и ее

физическое представление в системе. Более того, помимо системных ресурсов, о

которых мы сейчас говорили, ресурсами стали называть и такие объекты, как

сообщения и синхросигналы, которыми обмениваются задачи.

В первых вычислительных системах любая программа могла

выполняться только после полного завершения предыдущей. Поскольку эти первые

вычислительные системы были построены в соответствии с принципами, изложенными

в известной работе Яноша Джона фон

Неймана, все подсистемы и устройства компьютера управлялись исключительно

центральным процессором. Центральный процессор осуществлял и выполнение

вычислений, и управление операциями ввода-вывода данных. Соответственно, пока

осуществлялся обмен данными между оперативной памятью и внешними устройствами,

процессор не мог выполнять вычисления.

Введение в состав вычислительной машины специальных

контроллеров позволило совместить во времени (распараллелить) операции вывода

полученных данных и последующие вычисления на центральном процессоре. Однако

все равно процессор продолжал часто и долго простаивать, дожидаясь завершения

очередной операции ввода-вывода. Поэтому было предложено организовать так

называемый мультипрограммный, или мультизадачный, режим работы

вычислительной системы.

Мультипрограммирование,

многопользовательский

режим работы

и режим

разделения времени

Вкратце суть мультипрограммного режима работы заключается в

том, что пока одна программа (один вычислительный процесс, как мы теперь

говорим) ожидает завершения очередной операции ввода-вывода, другая программа

(а точнее, другая задача) может быть поставлена на решение (рис. 1.6). Это

позволяет более полно использовать имеющиеся ресурсы (например, центральный

процессор начинает меньше простаивать, как это видно из рисунка) и уменьшить

общее (суммарное) время, необходимое для решения некоторого множества задач.

Вв CPU Вв CPU

Рис. 1.6.

Пример выполнения двух программ в мультипрограммном режиме

На рисунке в качестве примера изображена такая

гипотетическая ситуация, при которой благодаря совмещению во времени двух

вычислительных процессов общее время их выполнения получается меньше, чем если,

бы их выполняли по очереди (запуск одного начинался бы только после полного

завершения другого). Из того же рисунка видно, что время выполнения каждого

процесса в общем случае больше, чем если бы мы выполняли каждый из них как

единственный.

При мультипрограммировании повышается пропускная

способность системы, но отдельный процесс никогда не может быть выполнен

быстрее, чем если бы он выполнялся в однопрограммном режиме (всякое разделение

ресурсов замедляет работу одного из участников за счет дополнительных затрат

времени на ожидание освобождения

ресурса).

Мультипрограммирование стало применяться все чаще и шире в

60-х годах XX века когда крупные компании получили,

наконец, возможность приобретать в собственность вычислительную технику и

использовать ее для решения своих задач. До этого времени вычислительная

техника была доступна, прежде всего, для военных целей и решения отдельных

задач общегосударственного масштаба. А поскольку стоимость компьютеров в то

время была чрезвычайно большой, то компании, вложив свои капиталы в вычислительную

технику, захотели за счет продажи машинного времени не только покрыть те

расходы, которые сопутствовали ее приобретению и использованию, но и

зарабатывать дополнительные деньги, то есть получать прибыль. Машинное время

стали активно продавать, сдавая в аренду имеющиеся компьютеры, и потенциальная

возможность решать в единицу времени большее количество задач, возможно от

разных клиентов, стала выступать основным стимулом в развитии способов

организации вычислений и операционных систем.

Задачи пользователей ставились в очередь на решение, и

распределение времени центрального процессора и других ресурсов компьютера

между несколькими выполняющимися вычислительными процессами позволяло

организовать параллельное выполнение сразу нескольких задач. Эти задачи могли

относиться и к одному пользователю, и к нескольким. Однако ставил их на решение

оператор вычислительной системы.

Приблизительно в то же время, может быть чуть позже, стали

активно развиваться всевозможные устройства ввода и вывода данных. Не стояло

на месте и системное программное обеспечение. Появилась возможность

пользователю самому вводить исходные данные и тут же получать результаты

вычислений, причем в удобном для него виде. Упрощение пользовательского

интерфейса и развитие интерфейсных функций операционных систем позволило

реализовать диалоговый режим работы. Как известно, диалоговый режим

предполагает, что пользователь может сам без посредника, взаимодействовать с

компьютером — готовить и запускать свои программы, вводить исходные данные,

получать результаты, приостанавливать вычисления и вновь их возобновлять и т.

д.

Очевидно,

что диалоговый режим работы может быть реализован и без мульти-

программирования. Наглядное тому доказательство —

многочисленные дисковые операционные системы, начиная от СР-М и кончая PC-DOS 7.0. которые долгие годы устанавливались на персональные

компьютеры и обеспечивали только однопрограммный режим. Однако эти

однопрограммные диалоговые системы появились гораздо позже мультипрограммных.

Как это ни кажется странным, им предшествовали многочисленные и разнообразные

операционные системы, позволяющие одновременно работать с компьютером большому

количеству пользователей и параллельно решать множество задач. Основная причина

тому — стоимость компьютера. Только с удешевлением компьютеров поя вилась

возможность иметь свой персональный компьютер, и первое время считалось, что

однопрограммного режима работы вполне достаточно. Главным для персональных

компьютеров до сих пор считается удобство работы, причем именно в диалоговом

режиме, простота интерфейса и его интуитивная понятность.

Совмещение диалогового режима работы с компьютером и режима

мультипрограммирования привело к появлению мулътитерминалъных, или

многопользовательских, систем. Организовать параллельное выполнение нескольких

задач можно разными способами. Если это осуществляется таким образом, что на

каждую задачу поочередно выделяется некий квант времени, после чего процессор

передается другой задаче, готовой к продолжению вычислений, то такой режим

принято называть режимом разделения времени (time sharing). Системы разделения времени активно

развивались в 60-70 годы, и сам термин означал именно мультитерминальную и

мультипрограммную систему. Итак, операционная система может поддерживать мультипрограммирование

(много-процессность). В этом случае она должна стараться эффективно

использовать имеющиеся ресурсы путем организации к ним очередей запросов,

составляемых тем или иным способом. Это требование достигается поддерживанием в

памяти более одного вычислительного процесса, ожидающего процессор, и более

одного процесса, готового использовать другие ресурсы, как только последние

станут доступными.

Общая схема выделения ресурсов такова. При необходимости

использовать какой-либо ресурс (оперативную память, устройство ввода-вывода,

массив данных и т. п.) вычислительный процесс (задача) путем обращения к супервизору1

(supervisor)

операционной системы посредством специальных вызовов (команд, директив)

сообщает о своем требовании. При этом указывается вид ресурса и, если надо, его

объем. Например, при запросе оперативной памяти указывается количество

адресуемых ячеек, необходимое для дальнейшей работы.

Команда обращения к операционной системе передает ей

управление, переводя процессор в привилегированный режим работы (см. раздел

«Прерывания»), если такой существует. Большинство компьютеров имеют два (и более) режима работы: привилегированный

(режим супервизора) и пользовательский. Кроме того, могут быть

режимы для эмуляции какой-нибудь другой ЭВМ или для организации виртуальной

машины, защищенной от остальных вычислений, осуществляемых на этом же

компьютере, и т. д. Мы уже говорили об этом, затрагивая вопрос организации

прерываний.

Ресурс может быть выделен вычислительному процессу

(задаче), обратившемуся к операционной системе с соответствующим запросом,

если:

·

ресурс

свободен и в системе нет запросов от задач более высокого приоритета к этому же

ресурсу;

·

текущий

запрос и ранее выданные запросы допускают совместное использование ресурсов;

·

ресурс

используется задачей низшего приоритета и может быть временно отобран

(разделяемый ресурс).

Получив запрос, операционная система либо удовлетворяет его

и возвращает управление задаче, выдавшей данный запрос, либо, если ресурс

занят, ставит задачу в очередь к ресурсу, переводя ее в состояние ожидания

(блокируя). Очередь к ресурсу может быть организована несколькими способами,

но чаще всего она реализуется с помощью списковой структуры.

После окончания работы с ресурсом задача опять с помощью

специального вызова супервизора (посредством соответствующей команды) сообщает

операционной системе об отказе от ресурса, либо операционная система забирает

ресурс сама, если управление возвращается супервизору после выполнения

какой-либо системной функции. Супервизор операционной системы, получив

управление по этому обращению, освобождает ресурс и проверяет, имеется ли

очередь к освободившемуся ресурсу. Если очередь есть, то в зависимости от

принятой дисциплины обслуживания' и приоритетов заявок он выводит из

состояния ожидания задачу, ждущую ресурс, и переводит ее в состояние готовности

к выполнению, после чего либо передает управление ей, либо возвращает

управление задаче, только что освободившей ресурс.

При выдаче запроса на ресурс задача может указать, хочет ли

она владеть ресурсом монопольно или допускает совместное использование с

другими задачами. Например, с файлом можно работать монопольно, а можно и

совместно с другими задачами. Если в системе имеется некоторая совокупность

ресурсов, то управлять их использованием можно на основе некоторой стратегии.

Стратегия подразумевает четкую формулировку целей, следуя которым можно

добиться эффективного распределения ресурсов.

При организации управления ресурсами всегда требуется принятъ

решение о том, что в данной ситуации выгоднее: быстро обслуживать отдельные

наиболее важные запросы, предоставлять всем процессам равные возможности или

обслуживать максимально возможное количество процессов и наиболее полно

использовать ресурсы.

Диаграмма

состояний процесса

Необходимо отличать системные управляющие вычислительные

процессы, определяющие работу супервизора операционной системы и занимающиеся

распределением и управлением ресурсов, от всех других процессов: задач

пользователей и системных обрабатывающих процессов. Последние, хоть и относятся

к операционной системе, но не входят в ядро операционной системы и требуют

общих ресурсов для своей работы, которые получают от супервизора. Для

системных управляющих процессов, в отличие от обрабатывающих, в большинстве

операционных систем ресурсы распределяются изначально и однозначно. Эти

вычислительные процессы сами управляют ресурсами системы, в борьбе за которые

конкурируют все остальные процессы. Поэтому исполнение системных управляющих

программ не принято называть процессами, и термин «задача» следует употреблять

только по отношению к процессам пользователей и к системным обрабатывающим процессам.

Однако это справедливо не для всех операционных систем. Например, в так

называемых «микроядерных» операционных системах большинство управляющих программных модулей

самой операционной системы и даже драйверы имеют статус высокоприоритетных

процессов, для выполнения которых необходимо выделить соответствующие ресурсы.

В качестве примера можно привести хорошо известную операционную систему реального

времени QNX фирмы Quantum Software Systems. Аналогично и в UNIX-системах, которые хоть и не относятся к микроядерным, выполнение

системных программных модулей тоже имеет статус системных процессов, получающих

ресурсы для своего исполнения.

Очевидно, что если некий вычислительный процесс (назовем

его первым) в данный конкретный момент времени не исполняется, поскольку

процессор занят исполнением какого-то другого процесса, то операционная

система должна знать, что вычисления в первом процессе приостановлены.

Информация об этом заносится в специальную информационную структуру,

сопровождающую каждый вычислительный процесс. Таких приостановленных процессов

может быть несколько. Они могут образовывать очередь задач, которые возобновят

свои вычисления, как только им будет предоставлен процессор. Некоторые

процессы, при своем выполнении требующие ввода или вывода данных, на время

выполнения этих запросов могут освобождать процессор. Такие события тоже

должны для операционной системы помечаться соответствующим образом. Говорят,

что процесс может находиться в одном из нескольких состояний. Информация о

состоянии процесса содержится в упомянутой выше информационной структуре,

доступной супервизору.

Если обобщать и рассматривать не только традиционные системы

общего назначения и привычные всем нам современные мультизадачные операционные

системы для персональных компьютеров, но и операционные системы реального

времени, то можно сказать, что процесс может находиться в активном и пассивном

(не активном) состоянии. В активном состоянии процесс может

конкурировать за ресурсы вычислительной системы, а в пассивном состоянии он

известен системе, но за ресурсы не конкурирует (хотя его существование в

системе и сопряжено с предоставлением ему оперативной и/или внешней памяти). В

свою очередь, активный процесс может быть в одном из следующих

состояний:

·

выполнения

— все затребованные

процессом ресурсы выделены (в этом состоянии в каждый момент времени может

находиться только один процесс, если речь

идет об однопроцессорной вычислительной системе);

·

готовности

к выполнению — ресурсы

могут быть предоставлены, тогда процесс перейдет в состояние выполнения;

·

блокирования,

или ожидания, —

затребованные ресурсы не могут быть предоставлены, или не завершена операция

ввода-вывода.

В большинстве операционных систем последнее состояние, в

свою очередь, подразделяется на множество состояний ожидания, соответствующих

определенному виду ресурса, из-за отсутствия которого процесс переходит в

заблокированное состояние.

В обычных операционных системах, как правило, процесс

появляется при запуске какой-нибудь программы. Операционная система организует

(порождает, или выделяет) для нового процесса уже упомянутую выше

информационную структуру — так называемый дескриптор процесса, и процесс

(задача) начинает выполняться. Поэтому пассивного состояния в большинстве

систем не существует. В операционных системах реального времени (ОСРВ)

ситуация иная. Обычно при проектировании системы реального времени состав

выполняемых ею программ (задач) известен заранее. Известны и многие их

параметры, которые необходимо учитывать при распределении ресурсов (например,

объем памяти, приоритет, средняя длительность выполнения, открываемые файлы,

используемые устройства и проч.). Поэтому для них заранее заводят дескрипторы

задач с тем, чтобы впоследствии не тратить драгоценное время на организацию

дескриптора и поиски для него необходимых ресурсов. Таким образом, в ОСРВ

многие процессы (задачи) могут находиться в состоянии бездействия, что мы и

отобразили на рис. 1.7, отделив это состояние от остальных состояний

пунктиром.

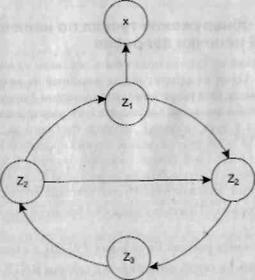

Рис. 1.7. Граф состояний процесса

За время своего существования процесс может

неоднократно совершать переходы из одного состояния в другое, обусловленные обращениями к операционной

системе с запросами ресурсов и выполнения системных

функций, которые предоставляет операционная система, взаимодействием с другими процессами, появлением сигналов прерывания от таймера,

каналов и устройств ввода-вывода, других устройств. Возможные переходы процесса

из одного состояния в другое отображены на рисунке и виде графа состояний.

Рассмотрим эти переходы из одного состояния в другое более подробно.

Процесс из состояния бездействия может перейти в состояние

готовности в следующих случаях.

·

По

команде оператора (пользователя). Имеет место в тех диалоговых операционных

системах, где программа может иметь статус задачи, даже оставаясь пассивной, а

не просто быть исполняемым файлом и получать статус задачи только на время исполнения

(как это имеет место в большинстве современных операционных систем, в том числе

и для персональных компьютеров).

·

При

выборе из очереди планировщиком (характерно для операционных систем,

работающих в пакетном режиме).

·

При

вызове из другой задачи (посредством обращения к супервизору один процесс

может создать, инициировать, приостановить, остановить, уничтожить другой

процесс).

·

По

прерыванию от внешнего инициативного устройства1 (сигнал о

свершении некоторого события может запускать соответствующую задачу).

·

При

наступлении запланированного времени запуска программы.

Последние два способа запуска задачи, при которых процесс

из состояния бездействия переходит в состояние готовности, наиболее характерны

для операционных систем реального времени.

Процесс, который может исполняться, как только ему будет

предоставлен процессор (а для диск-резидентных задач в некоторых системах и

оперативная память), находится в состоянии готовности. Считается, что такому

процессу уже выделены все необходимые ресурсы за исключением процессора.

Из состояния выполнения процесс может выйти по одной из

следующих причин.

·

Процесс

завершается, при этом он посредством обращения к супервизору передает

управление операционной системе и сообщает о своем завершении. В результате этих

действий супервизор либо переводит его в список бездействующих процессов

(процесс переходит в пассивное состояние), либо уничтожает. Уничтожается,

естественно, не сама программа, а именно задача, которая соответствовала

исполнению этой программы. В состояние бездействия процесс может быть переведен

принудительно: по команде оператора или путем обращения к супервизору

операционной системы из другой задачи с требованием остановить данный процесс.

Само собой, что действие по команде оператора реализуется системным процессом,

который «транслирует» эту команду в запрос к супервизору с требованием

перевести указанный процесс в состояние бездействия.

·

Процесс

переводится супервизором операционной системы в состояние готовности к

исполнению в связи с появлением более приоритетной задачи или в связи с

окончанием выделенного ему кванта времени.

·

Процесс

блокируется (переводится в состояние ожидания) либо вследствие запроса

операции ввода-вывода (которая должна быть выполнена прежде, чем он сможет

продолжить исполнение), либо в силу невозможности предоставить ему ресурс,

запрошенный в настоящий момент (причиной перевода в состояние ожидания может

быть отсутствие сегмента или страницы в случае организации механизмов

виртуальной памяти — см. раздел «Сегментная, страничная и сегментно-страничная

организация памяти» в главе 3), либо по команде оператора на приостанов

задачи, либо по требованию через супервизор от другой задачи.

При наступлении соответствующего события (завершилась

операция ввода-вы-вода, освободился затребованный ресурс, в оперативную память

загружена необходимая страница виртуальной памяти и т. д.) процесс

деблокируется и переводится в состояние готовности к исполнению.

Таким

образом, движущей силой, меняющей состояния процессов, являются события. Одним

из основных видов событий являются уже рассмотренные нами прерывания.

Реализация

понятия последовательного процесса в операционных системах

Для того чтобы операционная система могла управлять

процессами, она должна располагать всей необходимой для этого информацией. С

этой целью на каждый процесс заводится специальная информационная структура,

называемая дескриптором процесса (описателем задачи, блоком управления

задачей). В общем случае дескриптор процесса, как правило, содержит следующую

информацию:

·

идентификатор

процесса (Process

Identifier, PID);

·

тип

(или класс) процесса, который

определяет для супервизора некоторые правила предоставления ресурсов;

·

приоритет

процесса, в соответствии

с которым супервизор предоставляет ресурсы (в рамках одного класса процессов в

первую очередь обслуживаются более приоритетные процессы);

·

переменную

состояния, которая

определяет, в каком состоянии находится процесс (готов к работе, выполняется,

ожидает устройства ввода-вывода и т. д.);

·

контекст

задачи, то есть защищенную

область памяти (или адрес такой области), в которой хранятся текущие значения

регистров процессора, когда процесс прерывается, не закончив работы;

·

информацию

о ресурсах, которыми процесс владеет и/или имеет право пользоваться (указатели

на открытые файлы, информация о незавершенных операциях ввода-вывода и др.);

·

место

(или его адрес) для организации общения с другими процессами;

·

параметры

времени запуска (момент времени, когда процесс должен активизироваться, и

периодичность этой процедуры);

·

в

случае отсутствия системы управления файлами адрес задачи на диске в ее

исходном состоянии и адрес на диске, куда она выгружается из оперативной памяти,

если ее вытесняет другая задача (последнее справедливо для диск-резидентных

задач, которые постоянно находятся во внешней памяти на системном магнитном

диске и загружаются в оперативную память только на время выполнения).

Описатели задач, как правило, постоянно располагаются в

оперативной памяти с целью ускорить работу супервизора, который организует их в

списки (очереди) и отображает изменение состояния процесса перемещением

соответствующего описателя из одного списка в другой. Для каждого состояния

(за исключением состояния выполнения для однопроцессорной системы)

операционная система ведет соответствующий список задач, находящихся в этом

состоянии. Однако для состояния ожидания обычно имеется не один список, а

столько, сколько различных видов ресурсов могут вызывать состояние ожидания.

Например, состояний ожидания завершения операции ввода-вывода может быть

столько, сколько устройств ввода-вывода имеется в системе.

В некоторых операционных системах количество описателей

определяется жестко и заранее (на этапе генерации варианта операционной

системы или в конфигурационном файле, который используется при загрузке ОС), в

других по мере необходимости система может выделять участки памяти под новые

описатели. Например, в уже мало кому известной системе OS/2, которая несколько лет тому назад

многими специалистами считалась одной из лучших ОС для персональных

компьютеров, максимально возможное количество описателей задач указывается в

конфигурационном файле CONFIG.SYS.

Например, строка THREADS=1024 в файле CONFIG.SYS

означает, что всего в системе может параллельно существовать и выполняться до

1024 задач, включая вычислительные процессы и их потоки. В ныне широко

распространенных системах Windows NT/2000/ХР количество описателей нигде в явном виде не

задается. Это переменная величина, и она определяется самой операционной

системой. Однако посмотреть на текущее количество таких описателей можно.

Если, работая в Windows NT/2000/XP, нажать одновременно комбинацию клавиш Ctrl+Shift+Esc, появится окно Диспетчера задач. На вкладке Быстродействие этой

программы мы увидим поле с названием Всего дескрипторов и соответствующее

число. Тут же указывается количество дескрипторов для управления потоками

(задачами) и число полноценных вычислительных процессов. Более подробно о

процессах и потоках см. далее.

В операционных системах реального времени чаще всего количество

процессов фиксируется, и, следовательно, целесообразно заранее определять (на

этапе генерации или конфигурирования ОС) количество дескрипторов. Для

использования таких операционных систем в качестве систем общего назначения

(что нынче уже нехарактерно)1 обычно количество дескрипторов бралось

с некоторым запасом, и появление новой задачи связывалось с заполнением этой

информационной структуры. Поскольку дескрипторы процессов постоянно

располагаются в оперативной памяти (с целью ускорить работу диспетчера), то их

количество не должно быть очень большим.

Для более эффективной обработки данных в системах реального

времени целесообразно иметь постоянные задачи, полностью или частично всегда

существующие в системе независимо от того, поступило на них требование или нет.

Каждая постоянная задача обладает некоторой собственной областью оперативной

памяти (ОЗУ-резидентная задача, или просто резидентная задача) независимо

от того, выполняется задача в данный момент или нет. Эта область, в частности,

может использоваться для хранения данных, полученных задачей ранее. Данные

могут храниться в ней и тогда, когда задача находится в состоянии ожидания или

даже в состоянии бездействия.

Для аппаратной поддержки работы операционных систем с этими

информационными структурами (дескрипторами задач) н процессорах могут быть

реализованы соответствующие механизмы. Так, например, в микропроцессорах Intel 80x86 имеется специальный регистр TR (Task Register), указывающий местонахождение

специальной информационной структуры — сегмента состояния задачи (Task State Segment, TSS), в котором при переключении с задачи на

задачу автоматически сохраняется содержимое регистров процессора [1, 8, 48].

Поскольку между терминами «процесс» и «задача» со временем появилось существенное

различие, мы сейчас подробно рассмотрим этот вопрос.

Процессы

и задачи

Хотя понятия мультипрограммного и мультизадачного

режимов работы достаточно близки, это все-таки не одно и то же. К

сожалению, здесь до сих пор имеется некоторая путаница. Основные причины тому —

не только то, что терминология еще не устоялась и что многие фирмы-разработчики

по-разному предпочитали называть один и те же сущности, но и сложность, неоднозначность

ситуации.

Мультипрограммный режим предполагает, что операционная система

организует параллельное выполнение нескольких вычислительных процессов на одном

компьютере. И каждый вычислительный процесс может, в принципе, никак не зависеть

от другого вычислительного процесса. Разве что они могут задержать выполнение

друг друга из-за необходимости поочередно разделять ресурсы или сильно

задерживать выполнение друг друга при владении неразделяемым ресурсом. У них

может не быть ни общих файл он, ни общих переменных. Они вообще могут принадлежать

разным пользователям. Просто эти процессы, с позиций внешнего наблюдателя,

выполняются на одном и том же компьютере в одно и то же время. Хотя могут

выполняться и в разное время, и на разных компьютерах. Главное — это то, что

мультипрограммный режим обеспечивает для этих процессов их независимость.

Каждому процессу операционная система выделяет затребованные ресурсы, он

выполняется как бы на отдельной виртуальной машине. Средства защиты системы

должны обеспечить невмешательство одного вычислительного процесса в другой

вычислительный процесс. И если такую защиту обеспечить невозможно,

то система не может считаться надежной. Немало методов и

конкретных способов было придумано разработчиками для обеспечения надежных

вычислений и предотвращения возможности намеренно или по ошибке повлиять на

результаты вычислений в другом процессе.

Однако существует и другая потребность: не разделить

вычислительные процессы друг от друга, а наоборот совместить их, обеспечить

возможность тесного взаимодействия между осуществляемыми вычислениями.

Например, результаты вычислений одного вычислительного процесса могут

требоваться для начала или продолжения работы другого. Существует огромное

количество ситуаций, когда необходимо обеспечить активное взаимодействие между

выполняющимися вычислительными процессами. Если нет возможности получить

доступ к переменным другого процесса, ибо операционная система построена

надежно и защищает адресные пространства одного вычислительного процесса от

вмешательства другого вычислительного процесса, то возникают очень серьезные

препятствия на пути передачи каких бы то ни было данных между процессами.

Термин мультизадачный режим работы стали применять

как раз для тех случаев, когда необходимо обеспечить взаимодействие между

вычислениями. Мультизадачный режим означает, что операционная система

позволяет организовать параллельное выполнение вычислений, и имеются

специальные механизмы для передачи данных, синхросигналов, каких-либо сообщений

между этими взаимодействующими вычислениями. Это можно сделать за счет того,

что такие вычисления не должны системой изолироваться друг от друга.

Операционная система не должна для них в обязательном порядке задействовать все

механизмы защиты вычислений от невмешательства друг в друга. При

мультизадачном режиме разработчик программы должен позаботиться о разделении

ресурсов между его задачами. Операционная система будет всего лишь разделять

процессорное время между задачами. Понятие процесса было введено для

реализации идей мультипрограммирования. Термин задача тоже, к сожалению,

в большинстве случаев применялся для того же. В свое время различали термины

«мультизадачность» и «мультипрограммирование», но потом они стали заменять

друг друга, и это вносило немалую путаницу. Таким образом, для реализации

мультизадачности в ее исходном толковании необходимо было ввести

соответствующую сущность. Такой сущностью стали легковесные (thin) процессы, или. как их теперь

преимущественно называют, потоки выполнения1, нити, или треды

(threads).

Когда говорят о процессах (process), то тем самым хотят отметить, что операционная

система поддерживает их обособленность: у каждого процесса имеется свое

виртуальное адресное пространство, каждому процессу назначаются свои ресурсы —

файлы, окна, семафоры и т, д. Такая обособленность нужна для того, чтобы

защитить один процесс от другого, поскольку они, совместно используя все ресурсы

вычислительной системы, конкурируют друг с другом за доступ к ресурсам. В общем

случае процессы просто никак не связаны между собой и могут принадлежать даже

разным пользователям, разделяющим одну вычислительную систему.

Другими словами, в случае процессов операционная система

считает их совершенно несвязанными и

независимыми. При этом именно операционная система берет на себя роль арбитра в

спорах конкурирующих процессов за ресурсы. Она же и обеспечивает защиту

выполняющихся вычислений.

Однако желательно иметь еще и возможность задействовать

внутренний параллелизм, который может быть в самих процессах. Такой внутренний

параллелизм встречается достаточно часто и позволяет ускорить вычисления.

Например, некоторые операции, выполняемые приложением, могут требовать для

своего исполнения достаточно длительное использование центрального процессора.

В этом случае при интерактивной работе с приложением пользователь вынужден

долго ожидать завершения заказанной операции и не может управлять приложением

до тех пор, пока операция не выполнится до самого конца. Такие ситуации встречаются

достаточно часто, например, при работе с графическими редакторами при обработке

больших изображений с высокой степенью детализации. Если же программные

модули, исполняющие такие длительные операции, оформлять в виде самостоятельных